Sony macht bei der Entwicklung von Bildsensoren einen Schritt nach vorn: Bei den heute vorgestellten Typen IMX500 und IMX501 „Intelligent Vision Sensors“ ist die Logik des Bildprozessors in den Sensor-Chip integriert. Sony ist es zudem gelungen, KI-Funktionen direkt auf dem Sensor zu implementieren. Bis Fotokameras von der neuen Technologie profitieren, dürfte allerdings noch etwas Zeit vergehen – zunächst gibt es sie nur bei winzig kleinen Sensoren im Formfaktor 1/2,3 Zoll.

Als Anwendungsbeispiele für die Mini-Sensoren nennt Sony die Personenerkennung oder Überwachungsaufgaben. Zunächst dürften die neuen Sensoren also in Video- und Überwachungskameras eingesetzt werden, wo sie die Vorteile ihrer extrem hohen Signalverarbeitung ausspielen können.

Pressemitteilung von Sony Deutschland:

Sony bringt die weltweit ersten „Intelligent Vision Sensors“ mit KI-Verarbeitung auf den Markt

Die neuen Sensoren ermöglichen Edge AI-Verarbeitung in Hochgeschwindigkeit und erleichtern den Aufbau optimaler cloudvernetzter Systeme.

Berlin, 14. Mai 2020. Die Sony Corporation gab heute die Einführung zweier „Intelligent Vision Sensors“ bekannt – der weltweit ersten Bildsensoren mit KI-Verarbeitungsfunktion.1 Die Integration der KI-Verarbeitungsfunktion direkt in den Bildsensor bedeutet, dass die Daten über Edge-AI in Hochgeschwindigkeit verarbeitet werden können und nur die erforderlichen Daten extrahiert werden. Dies ermöglicht es, bei der Nutzung von Cloud-Diensten die Latenzen bei der Datenübertragung zu verkürzen, Datenschutzvorgaben Rechnung zu tragen und den Energieverbrauch sowie die Kommunikationskosten zu senken.

Die „Intelligent Vision Sensors“ eröffnen neue Möglichkeiten zur Entwicklung KI-fähiger Kameras. Sie können eine Vielzahl von Anwendungen im Einzelhandel und Industrieausrüstungssektor unterstützen und den Aufbau optimaler, mit der Cloud verbundener Systeme erleichtern.

Mit dem Aufstieg des IoT werden Geräte aller Art mit der Cloud verbunden. So ist heute der Einsatz von Informationsverarbeitungssystemen gang und gäbe, bei denen die Daten, die diese Geräte liefern, mit künstlicher Intelligenz in der Cloud verarbeitet werden. Die zunehmende Datenverarbeitung in der Cloud wirft allerdings auch eine Reihe von Herausforderungen auf: höhere Latenzen bei der Datenübertragung, die die Informationsverarbeitung in Echtzeit behindern, Sicherheitsbedenken seitens der Nutzer, wenn personenbezogene Daten in der Cloud gespeichert werden und weitere Probleme, wie etwa der erhöhte Energieverbrauch und die Kommunikationskosten, die Cloud-Dienste mit sich bringen.

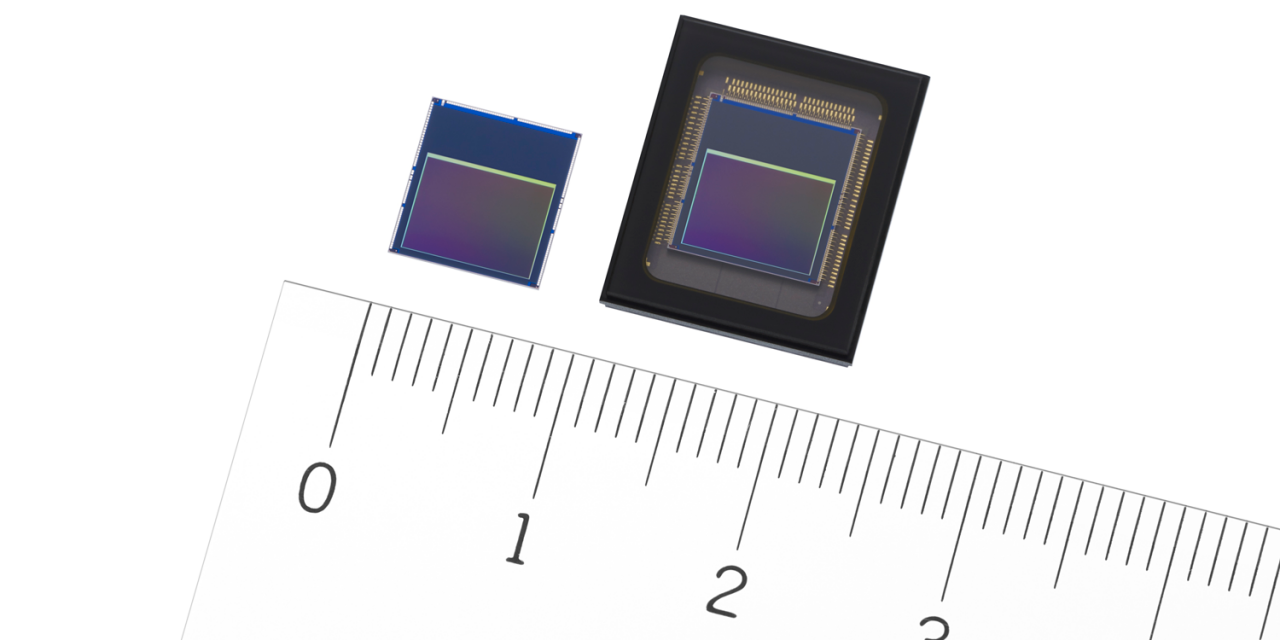

Die neuen Sensoren sind gestapelt („stacked“) aufgebaut und bestehen aus einem Pixelchip und einem Logikchip. Es sind die weltweit ersten Bildsensoren, bei denen die künstliche Intelligenz zur Bildanalyse und Bildverarbeitung in den Logikchip integriert ist. Das Signal, das der Pixelchip erfasst, wird durch die KI auf dem Sensor verarbeitet, sodass keine Hochleistungsprozessoren oder externen Speicher benötigt werden. Dies ermöglicht die Entwicklung von Edge-AI-Systemen. Der Sensor gibt anstelle von Bildinformationen Metadaten aus (d.h. semantische Informationen zu den Bilddaten), was die Datenmengen reduziert und Datenschutzbedenken Rechnung trägt. Darüber hinaus ermöglicht die KI-Fähigkeit, vielfältige Funktionen für ein breites Spektrum von Anwendungen bereitzustellen, wie etwa Echtzeit-Objektverfolgung mit KI-Verarbeitung in Hochgeschwindigkeit. Die Benutzer können auch andere KI-Modelle wählen: Dazu wird der interne Speicher entsprechend den jeweiligen Anforderungen oder den Bedingungen am Einsatzort des Systems neu beschrieben.

Die wichtigsten Merkmale:

Der weltweit erste Bildsensor mit KI-Verarbeitungsfunktion

Der Pixelchip ist hintergrundbeleuchtet und verfügt über ca. 12,3 effektive Megapixel zur Erfassung von Informationen über einen weiten Betrachtungswinkel. Neben der herkömmlichen Bildsensor-Betriebsschaltung ist der Logikchip mit dem DSP (Digitaler Signalprozessor) von Sony ausgestattet, der die KI-Signale verbreitet, sowie einem Speicher für das KI-Modell. Diese Bauweise macht den Einsatz von Hochleistungsprozessoren oder externen Speichern überflüssig und eignet sich daher ideal für Edge-AI-Systeme.

Metadatenausgabe

Die Signale, die der Pixelchip erfasst, werden durch einen ISP (Bildsignalprozessor) geleitet. Die KI-Verarbeitung erfolgt in der Prozessstufe auf dem Logikchip, und die extrahierten Informationen werden als Metadaten ausgegeben, was das Datenvolumen reduziert. Da keine Bildinformationen ausgegeben werden, werden die Sicherheitsrisiken verringert, und der Datenschutz ist gewährleistet. Zusätzlich zu dem Bild, das der konventionelle Bildsensor aufzeichnet, können die Benutzer je nach den individuellen Anforderungen und Einsatzzwecken auch andere Datenausgabeformate wählen. Dazu zählen die Ausgabe von Bildern im ISP-Format (YUV/RGB) und die Ausgabe bestimmter ROI (Region of Interest)-Bildbereiche.

KI-Verarbeitung in Hochgeschwindigkeit

Wenn ein Video mit einem herkömmlichen Bildsensor aufgezeichnet wird, müssen die Daten für jedes einzelne Ausgabebild an die KI-Verarbeitung gesendet werden. So müssen große Datenmengen übertragen werden, und es wird schwer, Echtzeitleistung zu erreichen. Die neuen Sensoren von Sony führen die ISP-Verarbeitung und die Highspeed-KI-Verarbeitung (3,1 Millisekunden Verarbeitungszeit für MobileNet V12) auf dem Logikchip aus und schließen den gesamten Prozess in einem einzigen Videobild ab. Dieses Design ermöglicht eine hochpräzise Echtzeitverfolgung von Objekten bei Videoaufnahmen.

Wählbares KI-Modell

Die Benutzer können die KI-Modelle ihrer Wahl in den eingebetteten Speicher schreiben und sie je nach ihren Anforderungen oder den Bedingungen am Einsatzort des Systems auch neu schreiben und aktualisieren. Wenn beispielsweise mehrere Kameras, die diesen Sensor nutzen, in einem Ladengeschäft installiert sind, lassen sich mit einem einzigen Kameratyp verschiedene Standorte, Bedingungen, Zeiten oder Zwecke abdecken. Wird die Kamera im Eingangsbereich installiert, können damit die Kunden gezählt werden, die das Geschäft betreten. Wird sie an einem Regal angebracht, kann damit erkannt werden, wo Waren fehlen. Wenn die Kamera an der Decke installiert ist, kann sie zur Erstellung von Wärmebildern genutzt werden (um Bereiche zu erkennen, in denen viele Ladenbesucher zusammentreffen) und dergleichen mehr. Darüber hinaus kann das KI-Modell in einer Kamera neu geschrieben werden, sodass beispielsweise aus einem Modell zur Erkennung von Heatmaps ein Modell zur Ermittlung des Kundenverhaltens wird.

Das sind garantiert Algorithmen, aber keine KI. Für KI ist das Gehäuse viel zu klein, da gehört mehr Rechenpower dazu. Traurig, dass mit KI so viel Werbung gemacht wird, obwohl Unternehmen wie Sony den Unterschied wissen müssten.