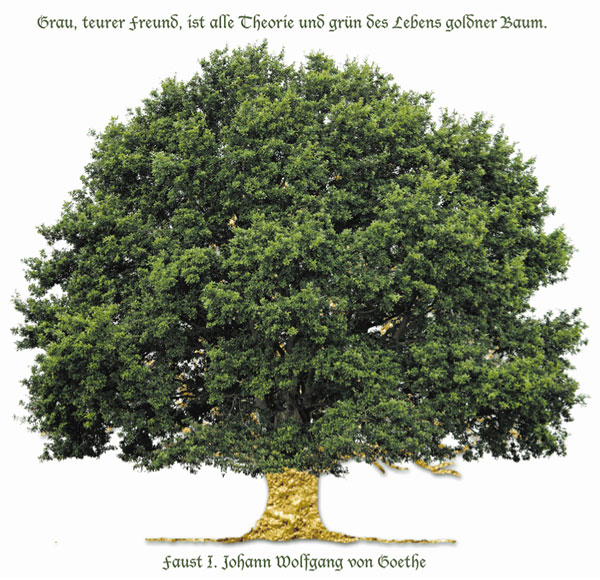

„Grau, teurer Freund, ist alle Theorie, und grün des Lebens goldner Baum.“ (Goethe, natürlich) – Wie sich die Farberfassung des Bildsensors auf die Bildqualität auswirkt. Oder auch: Auf der Suche nach den guten und den schlechten Pixeln:

„Grau, teurer Freund, ist alle Theorie, und grün des Lebens goldner Baum.“ (Goethe, natürlich) – Wie sich die Farberfassung des Bildsensors auf die Bildqualität auswirkt. Oder auch: Auf der Suche nach den guten und den schlechten Pixeln:

Ebenso paradox wie Goethes Zitat (der goldene Baum ist grün) ist ein Effekt, den ich im Folgenden näher untersuchen werde und der sich stark verkürzt und zugespitzt so beschreiben lässt: je mehr Farbe ein Sensor „sieht“, desto schlechter wird das Bild.

Es gab ganz pragmatische Gründe, mich mit den grünen und nicht so grünen Schattierungen eines Baums zu beschäftigen, hatte ich doch in der letzten Zeit von unterschiedlichen Herstellern verschiedene Kameramodelle zur Probe bei mir zu Hause. Deshalb mußte ich auch schmunzeln, als am Freitag, den 14. Februar 2014, auf photoscala ein Beitrag von thoMas zum Thema Bildqualität zu lesen war und ich darin meine Sichtweise grundsätzlich bestätigt sah. Wer sich in der Materie auskennt, wird die Ergebnisse, die mit den heutigen Kameramodellen zu erzielen sind, nicht ernsthaft schlecht reden. Natürlich wird man, wenn man will, immer ein Haar in der argumentativen Suppe finden können.

So mag man über Pixelpeeper lächeln. Doch ich bin es von klein auf gewohnt, mit dem Fadenzähler das Bildergebnis aufs Korn zu nehmen und deshalb scheue ich mich auch heute nicht, auf der Suche nach guten und schlechten Pixeln vehement in bestimmte Details hinein zu zoomen. Bei meinen Vergleichen fiel mir auf, dass die erwartungsgemäß guten Ergebnisse bei bestimmten Motiven – und auch da nur auf einige Bereiche begrenzt – etwas schwächelten. Um nachzuvollziehen, was dieses Schwächeln verursachte, entwickelte ich entsprechende Testcharts, mit deren Hilfe diese Artefakte eindeutig nachgewiesen werden können.

Damit meine Vorgehensweise verständlicher wird, erlaube ich mir einen kleinen Exkurs. Zunächst geht es um die lapidare Feststellung, dass jedem Farbwert ein entsprechender Grauwert zugeordnet werden kann. Wandelt man die untere linke, bunte Abbildung in ein Graustufenbild, ist eine homogene Graufläche zu sehen:

Bis hier stimmen Theorie und Praxis überein, aber wie sieht es mit dem Baum aus? Um dies zu überprüfen und visuell darzustellen, bietet sich die GCR-Separation* an, da es hierbei möglich ist, den unbunten Grauanteil des farbigen – präziser des bunten – Bildes, zu separieren. (* Bei der GCR-Separation werden gleiche Teile CMY durch Schwarz ersetzt.)

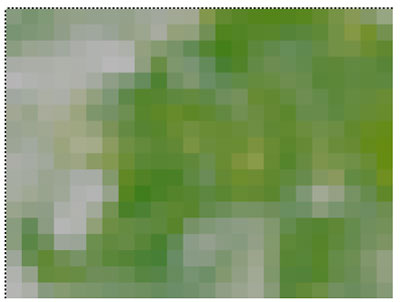

Hier das Ergebnis als Ausschnitt:

Links ein Teil der Baumkrone, rechts ein separierter Ausschnitt davon.

Es fällt der recht hohe Grauanteil in dem Bild auf und die – durch den fehlenden Schwarzanteil – undifferenzierte Wiedergabe des Buntanteils. Der Ausschnitt rechts hat die Größe von 240×180 Pixeln (im Original, hier leicht anders skaliert). Der folgende Ausschnitt zeigt lediglich 24×18 Pixel daraus und gibt ganz deutlich wieder, wie unpräzise und verwaschen sich der Buntanteil vom Grauanteil abgrenzt. Es wird damit deutlich, dass die farbliche Differenzierung nur durch den Schwarzanteil gewährleistet wird und dass dieser Anteil selbstverständlich ebenfalls unbunt = grau ist.

Soweit die Grundlagen und die daraus resultierende Frage:

Wie gehen die Kameras mit bunten und unbunten Informationseinheiten um?

Für die darauf folgende Testreihe standen mir folgende Kameramodelle zur Verfügung:

1. Nikon D800E

2. Nikon D3X

3. Canon 5D

4. Nikon D90

5. Canon 550D

6. Pentax 20D

Da es Spannenderes gibt, als endlose Testreihen zu begutachten, beschränke ich mich auf die wesentlichen Punkte, die auffällig sind und alle Kameras gleich betreffen:

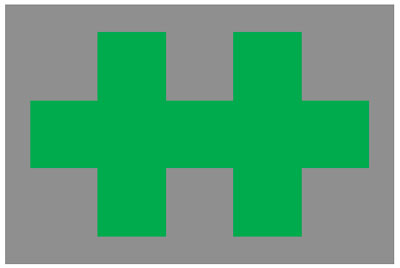

Zunächst zu den Testcharts – diese sind im CMYK-Modus generiert worden und bestehen aus unterschiedlichen Elementen, deren bunte und unbunte Anteile den gleichen Luminanzwert haben. Das kleinste Element hat eine Größe von 1 mm, das größte mißt 2,5 mm. Diese Elemente haben einen wellenförmigen Versatz von 0,02 mm. Zusätzlich gibt es die üblichen Linienscharen, sowie Kreisobjekte, die allerdings ebenfalls im Wechsel durch bunte und unbunte Linien gleicher Luminanz ausgeführt sind. Die Auswertung der Testreihen erfolgte mit der GCR-Max-Separation, um die oben ausgeführten Voraussetzungen zu schaffen. Die nächste Abbildung zeigt ein typisches Grundelement, mit dem die Testcharts gestaltet wurden:

Mit meinen Versuchen wollte ich folgenden Fragen auf den Grund gehen:

• Wird das bunte Objekt vom grauen Umfeld aufgeweicht oder gibt es eine klare Farbwerttrennung?

• Spielen die unterschiedlichen Auflösungswerte dabei eine Rolle und ist deshalb die Nikon D800E eindeutig im Vorteil?

Um gleich die letzte Frage als erste zu beantworten: Die Auflösung der Nikon D800E ist erwartungsgemäß am besten, gefolgt von der D3X. Aber – und jetzt kommt das vielleicht Überraschende: Die Auflösung spielt bei der Beantwortung der ersten Frage keine Rolle! Doch warum ist das so?

Um eine exakte Trennung von Bunt- und Neutralflächen zu erreichen, wurden die Testdateien in den CMYK-Modus konvertiert. Durch die Separationsoption

werden die gesamten Unbuntanteile eines Farbbildes in den Schwarzkanal separiert, d.h. alle von der Kamera erfassten Neutralwerte lassen sich fein säuberlich per Schwarzkanal begutachten, alle Buntanteile finden sich in den Farbkanälen C, M, Y wieder.

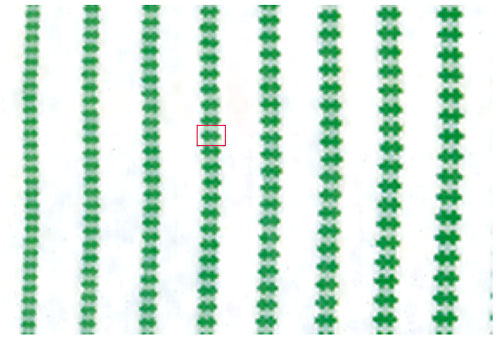

Das Ergebnis der abfotografierten Testtafel stellt sich dann so dar:

Ausschnitt eines Testcharts – aufgenommen mit der Nikon D800E.

Zur Orientierung: Die ausgewählten Objekte haben eine Länge von 1 bis 1,7 mm.

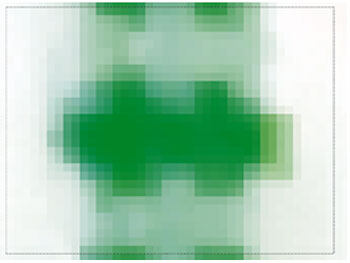

Diese Abbildung zeigt ein 30×40 Pixel großes Objekt aus obiger Testtafel-Aufnahme.

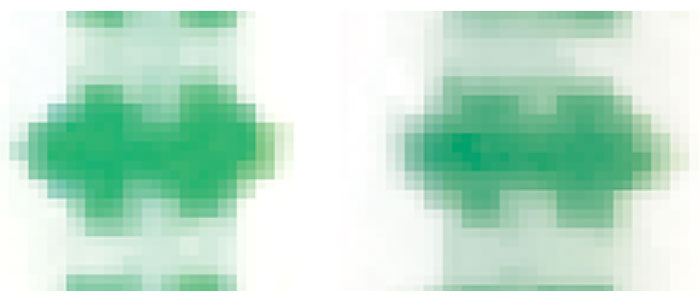

Erneut ein 30×40 Pixel großes Objekt, diesmal mit der Nikon D3X belichtet, und mit der Canon 5D.

Die Ergebnisse sind frappierend – alle Kameras zeigen den gleichen, und wie ich finde, unerwünschten Effekt: erhöhte Farbsättigung respektive Verlust des Neutralanteils, was in Konsequenz einen mehr oder weniger strukturlosen Farbbrei ergibt. Auch die gleich großen Objekte, welche mit den APS-C Kameras erfaßt wurden, gleichen sich diesbezüglich wie ein Ei dem anderen und können nicht von den Ergebnissen der Vollformatkameras unterschieden werden!

Bei allen Kameras dasselbe Ergebnis: Alle bunten Objekte strahlen in die umgebende Graufläche hinein und bilden einen deutlichen Farbsaum. Wir haben es hier gewissermaßen mit dem Phänomen einer isoluminanten (gleichhellen) Farbübertragung zu tun, die sich unabhängig von der vorhandenen Auflösung feststellen läßt. Weil sich die isoluminante Farbübertragung quasi im Verborgenen abspielt, möchte ich diesen Vorgang scherzhaft den

nennen.

Was für Schlüsse lassen sich aus diesen Ergebnissen ziehen?

Wäre dieser Effekt nur unter den oben genannten Bedingungen relevant, könnte man schnell zur Tagesordnung übergehen. Es interessieren aber die Auswirkungen für die Praxis und hierzu läßt sich Folgendes feststellen: Wie bereits beim Beispiel des Baums gezeigt wurde, ist für die Wirkung eines Farbbildes der Komplementärfarbanteil von entscheidender Bedeutung. Wird dieser Anteil reduziert und die Farbsättigung erhöht, reduziert sich auch die Durchzeichnung. Eine rote Tomate leuchtet dann knallrot und wird zu einem zweidimensionalen Farbklecks reduziert. Genau dies kennzeichnet den Heinzelmann-Effekt.

Der Heinzelmann-Effekt findet allerdings nur in den Mikrostrukturen statt! Diese werden übersättigt, d. h. die neutralen strukturgebenden Anteile werden reduziert. So kommt es zu einer paradoxen Bildqualität: Mit höheren Auflösungen geht zwangsläufig eine Vervielfachung der Mikrostrukturen einher. Einerseits werden mehr Details darstellbar, andererseits bewirkt der Heinzelmann-Effekt, dass über alle Kameratypen und -modelle hinweg wichtige Bildinformationen einfach im digitalen Bermuda-Dreieck verschwinden.

Zusammenfassung:

• Mehr Auflösung = mehr Detail

• Mehr Details = mehr Mikrostrukturen

• Mehr Mikrostrukturen = mehr Zeichnungsverlust*

(* In Anhängigkeit der Luminanzwerte des effektiven Neutralanteils.)

Zum Schluß noch eine kleine Demonstration des soeben festgestellten Befundes:

In Bildmitte ist ein ausgehöhlter Baumstamm zu sehen. Im 100-%-Beschnitt (ganz links) läßt sich schon vage erkennen, was bei 400-%-Vergrößerung (links) gut sichtbar wird. Rechter Hand wurde ein Ausschnitt von 18×24 Pixeln lediglich hochgezoomt und ganz rechts ist dessen Buntanteil (oben) getrennt vom Schwarzanteil (unten) zu sehen. Auch wenn die 432 Pixel nur schemenhaft wiedergeben, was bei 400-%-Vergrößerung klar zu erkennen ist: ohne den Unbuntanteil wäre lediglich ein brauner Farbtupfer auszumachen – und der eben beschriebene „Heinzelmann-Effekt“ reduziert eben den Unbuntanteil mehr oder weniger.

Es liegt nahe, die Ursache für die isoluminanten Farbverschiebungen in der spezifischen Struktur der Bayer-Sensoren zu suchen. In einem zweiten Beitrag soll das näher untersucht werden: Der Heinzelmann-Effekt II (ist ab Samstag, 31.5.2014 um 9:45 Uhr online). Dann werden wir auch die guten Pixel finden – machen Sie sich auf eine Überraschung gefasst.

(Heiner Muskulus)

ähmmm … und was bedeutet das jetzt konkret?

sorry, aber mich lassen diese ab und zu hier auf photoscala vorkommenden eigenartig theoretischen Exkurse – egal ob von Chris h. oder sonst jemand – immer absolut ratlos zurück. Was wollt ihr mir sagen?

Was heißt das jetzt? Dass man (mehr-) farbige Motive mit Farbsensoren fotografieren sollte? Oder doch mit einer monochromen Leica? Oder dass eine 3000 Euro teure D800E bei bestimmten Motiven genau so für die Würscht ist wie eine 300 Euro APS-C Kamera von vor 7 Jahren? Oder nur dann, wenn man die Bilder in Farbe und schwarz aufsplittet?

Was ist an dem loch im Baum in der Praxis relevant? Im Gesamtbild sieht man den Pilz genau so wenig, wie man ihn frei Aug im Wald aus der Entfernung sehen würde. Was macht man mit 400% Vergrösserungen? Und nein, ich gehöre nicht zur Fraktion derer, die stets meinten 6 Megapixel seien mehr als genug “für alles”.

Also, was mich betrifft

so wollte ich einfach ein paar Denkanstöße zur Theorie und Praxis der Digitalfotografie liefern.

So weit scheine ich mit dem Kollegen hier konform zu gehen; wiewohl ich mich nicht im Detail mit den Wirkungen des Bayer-Sensors auseinandergesetzt, sondern nur die unter Fotografen durchaus verbreitete Meinung vertreten und publiziert habe, dass diese Sensorstruktur und deren Auswirkungen auf Farbwiedergabe und Auflösungsvermögen schlicht als mangelhaft zu werten sind – unabhängig vom subjektiven Befinden, ob man man sich damit zufrieden gibt oder nicht.

Zum vorliegenden Beitrag geb ich gern dann noch meinem Senf dazu, wenn der zweite Teil der Betrachtung vorliegt – dem ich mit Spannung harre.

Geht mir genauso.

Was will uns der Künstler jetzt damit sagen? Das es bei der Demosaizierung des Bayer Patterns Artefakte gibt? Das das JPEG-Kompressionsverfahren Artefakte hervorruft? Dass Wasser naß ist?

Besonders drollig: Einem unerwünschten Artefakt auch noch als Effekt zu adeln, wenn auch nur mit einen “scherzhaften” Namen, statt einfach nur zu schreiben: Sehr her Leute es gibt Artefakte bei der Rekonstruktion. Und dann gibt es auch noch beim Speichern in JPEG Artefakte…

Trollig nur

dass diese Artefakte – die noch dazu nicht nur “Artefakte” zu sein scheinen, sondern sehr regelmäßige Ausfälle – niemanden ernsthaft stören … es sei denn, es kommt einer daher, und stößt uns mit dem Näschen ins Häufchen, dann ist es das Natürlichste von der Welt. 😎

Unterschiedliche Farben

[quote=Gast][quote=Gast]Und da ist mir aufgefallen, dass das alles andere als einfach ist. Denn je nach gewähltem Raw Konverter kommen, aus ein und derselben Datei, doch ziemlich abweichende Farben hervor. [/quote]

Und bei gleichem RAW-Konverter gibt es bei ansonsten identischen Einstellungen noch unterschiedliche Farben je nach Kamera/Farbprofil. Objektiv richtige Farben sind ein schwieriges Thema. Wer mag, der kann sich ein Farbprofil selbst erstellen, aber auch das ist nicht trivial. Insoweit ist’s letztlich doch eine Frage der persönlichen Beurteilung, was “richtig” aussieht nach den persönlichen Kriterien.[/quote]

Differenzierte Farben im Input sind in einem Farbmanagement-System kein Problem, denn alles, was ab RAW-Konverter herauskommt, hat genau die richtigen Werte. Nämlich die, die man selbst festgelegt hat.

Gut Licht!

Und was man erst

aus der gequirlten Sch…. von den Kommrntatoren selbst lernt … das spricht schon sehr für thoMas’ Reputation als liberaler Freigeist. 😎

Wir färben uns die Welt

wiedewiede wie sie uns gefällt … Dir fehlt einfach der Sinn für die superdemokratische Selbstlegitimation. 😎

Was man nicht versteht….

[quote=Gast]Immerhin haben wir dank seiner gequirlten Schei*** ne Menge in den Kommentaren gelernt… Photoscala hat schon ein geballtes Fachwissen im Publikum. Warum nur muss der thoMas dann durch unausgegorenen Quatsch wie diesem hier seine eigene Reputation kaputtmachen…?[/quote]

…ist immer Quatsch……

Nicht selten

ist sogar das Quatsch, was man zu verstehen meint … Hauptsache es wird von einer kritischen Masse geteilt, dann ist es unverrückbarer Bestandteil bornierter Weltsichten. 😎

Ich wollt’s nicht

zu banal formulieren – aber die Graukarte allein ist schon mal sehr nutzbringend; wenngleich ich für meine Cam eine mit etwa 10% Reflexion bevorzugen würde …

+1

+1

Damit

[quote=Gast][quote=Gast]P. S.: Lieber Herr Maschke, bitte veröffentlichen Sie in Zukunft nur wissenschaftlich fundierte Artikel von Autoren mit entsprechender Ausbildung. [/quote]

Der Bitte und Einschätzung möchte ich mich anschliessen.[/quote]

soziale Inkompetenz und Problemlösungsineffizienz wissenschaftlich prolongiert wird …? 😎

Das

wissenschaftliche Urvertrauen ist seit der Atombombe ein ungebrochenes. Und den Finanzcrash wird’s auch noch überleben. 😉

Wozu?

[quote=Gast]Damit soziale Inkompetenz und Problemlösungsineffizienz wissenschaftlich prolongiert wird …? [/quote]

“Jugend forscht” in allen Ehren … Es ist aber nicht mit bahnbrechenden neuen Lösungsansetzen zu rechnen, nur weil interessierte Nichttechniker auf photoscala lange Artikel schreiben, in denen sie bekannte Zusammenhänge didaktisch-fachlich ungeschickt darstellen und ihnen neue Namen geben.

Die bahnbrechenden

Lösungsansätze stammten immer schon oft von Geistern, die sich nicht den (Denk)Schranken bekannter (sic!) Zusammenhänge unterworfen haben. Dieser Zugang fehlt Wissenschaftlern und Technikern, die allein kraft Ihrer Titel und ihres erworbenen Wissens auf ihrer Kompetenz beharren.

Warum kein CCD Sensor im Vergleich?

Es würde mich interessieren, wie sich im Vergleich ein CCD Sensor schlagen würde;

der Testchart als Datei und eine Anleitung zur Konvertierung in würden den Bericht vervollständigen.

Ein CCD

arbeitet auch nur auf Bayer-Basis.

Was

[quote=Gast]

was der Herr Physiker sagt, stimmt zumindest z. T. [/quote]

der Geoleoge aber nun wirklich nicht beurteilen kann, es sei denn, er hätte auch Mathematik studiert!

Die Relativität

[quote=Gast][quote=Gast]Lösungsansätze stammten immer schon oft von Geistern, die sich nicht den (Denk)Schranken bekannter (sic!) Zusammenhänge unterworfen haben. Dieser Zugang fehlt Wissenschaftlern und Technikern, die allein kraft Ihrer Titel und ihres erworbenen Wissens auf ihrer Kompetenz beharren.[/quote]

Das klingt schön. Das Überwinden von Denkschranken sollte man aber nicht mit Unwissen verwechseln. Bei den Themen, über die wir hier sprechen, sind die Zusammenhänge gut bekannt und gut verstanden. Letzteres allerdings nicht von jedem.[/quote]

von (Un)Wissen wird nur von bornierten Geistern in Abrede gestellt: Fachidioten im ausgeprägtesten Sinn des Wortes.

Nö

das gilt heute noch genau so … man zündet halt keine Scheiterhaufen, diese Brandherde der Aufklärung, mehr an. Was überkommene Denkmuster aber auch nicht vor der Einäscherung, dem Flächenbrand der kommende Aufklärung, bewahren wird … 😎

Moby Dick

Wal, da bläst er … 😉

Und noch einer

der die Ursache für mangelhafte Digitalaufzeichnung im Bayer-Sensor sucht, und wohl auch finden wird … aber wir leben ja in der besten aller digitalen Welten. 😎

Neu

Zitat: “Es liegt nahe, die Ursache für die isoluminanten Farbverschiebungen in der spezifischen Struktur der Bayer-Sensoren zu suchen.”

Bayer-Sensoren, AA-Filter und Schärfungsalgorithen … wirklich überraschend sind die beobachteten Effekte soweit noch nicht. Trotzdem vielen Dank für den Artikel, auch wenn man das Thema vielleicht etwas kompakter abhandeln könnte.

Alteranive Sensoren

Mich interessieren auch die Alternativen, wie die so sind. Foveon… und andere wenn es die gibt. Danke für den kompakten Artikel mit seinen greifbaren Beispielen. Für mich ist es eine neue Seite der Sensortechnik.

.

Die Frage haben sich wahrscheinlich schon viele gestellt:

Warum sieht die schöne neue Digitalwelt trotz (angeblich) überragender Auflösung, Kornfreiheit, grandioser Testchart-Farbtreue und HDR noch immer so unglaublich besch….eiden aus?

Auch wenn man sich mittlerweile anschaut, welchen Augenkrebs im Videospiel-Look Hollywood bei digitalen 100-Mio-Dollar Blockbustern auf die Menschheit loslässt (und wie der Schrott dann bei BluRay-Besprechungen noch regelmäßig höchste Bewertungen für die “grandiose Bildqualität” bekommt), könnten einem Zweifel am Fortschritt kommen. Wahrscheinlich sind die Zeiten natürlicher und ästhetisch ansprechender Bildwiedergabe endgültig vorbei; heute gehts nur noch um Bonbonfarben per look-up-table (inkl. demokratischen Standardhautton für alle), beliebige Scharfzeichnung und Gradationskurven aus Plastilin – es muss halt “knallen”. Das ist ein bisschen wie bei der U-Musik, wo die Studiotechnik auch immer “besser” (oder auch nur komplexer und aufwendiger) wird, und trotzdem tut alles nur noch in den Ohren weh.

Seit den händisch angefertigten Farbauszügen der 50er geht es mit der Wiedergabequalität bei Fotos aber eh nur noch bergab (und das ist jetzt nicht einmal ironisch gemeint).

Selbst die Kommentare waren

Selbst die Kommentare waren früher besser.

Der Hauptgrund

ist wohl im “superdemokratischen” Medium Digitalfotografie an sich zu suchen. Wobei hier ein offensichtliches Missverständnis zwischen Verbindlichkeit und Beliebigkeit vorliegt. Und das Konstrukt der Sensoren, wie auch die Struktur der Datenverarbeitung fördert diese Herangehensweise nachhaltig. Das war und ist halt auf Film nicht oder nicht in diesem Umfang möglich – was aber nicht zum Irrtum verleiten sollte, dass da noch alles gut oder gar besser war.

Jedenfalls täte der digitalen Aufnahmetechnik ein verbindlicher Standard gut, der nicht nur nicht so eingeschränkt hinsichtlich seines Wiedergabevermögens wäre – und demnach geradezu nach Manipulation verlangt -, sondern dessen Programmierung die Vorteile des digitalen Mediums in ein Format überführt, das unter unterschiedlichsten Licht- und Kontrastverhältnissen ein direkt verwendbares Ergebnis liefert; das natürlich auch manipulierbar wäre, aber vorwiegend als verbindliches “RAW-Ausgabeformat” auch digitale Aufnahmen vom Geruch der Beliebigkeit zumindest freispielen könnte.

Bitte nicht…

Geht das jetzt schon wieder los? – Naja, es gibt nichts mehr zu fotografieren, klar (ausser Auftragsarbeiten), aber wie wäre es, sich mal neue Felder zu erschliessen (Webdesign – hochspannend), anstatt hier eine weitere unfruchtbare Diskussion anzustoßen, die die Welt nicht braucht?

Gut Licht!

Gute Nacht!

[quote=Gast]Geht das jetzt schon wieder los? [/quote]

Wieder nix kapiert? Gute Nacht, schlaf weiter!

Doch

[quote=Gast]Geht das jetzt schon wieder los? – Naja, es gibt nichts mehr zu fotografieren,

Gut Licht![/quote]

GRAUKARTEN! Dann gibbet es nix mehr zu meckern und entbehrt jeden Versuch obskure Vergleiche anzustellen, welche sich in der Praxis eh nicht oder nur marginal auswirken! Um mehr zu sehen als ein Adler müsste es in der Sensor- und Objektivtechnik schon eine gewaltige Revolution geben! Selbst die optischen Spioagemittel aus dem Weltraum sind nicht allmächtig!

Konvertierung

der demonstrierte Heinzelmann Effekt ist ja für sich genommen schom mal sehr interessant und ich bin auf den zweiten Teil gespannt.

Was mich beschäftigt ist, dass ich (mache Naturfotos) eine möglichst naturnahme Farbwiedergabe bevorzuge. Und da ist mir aufgefallen, dass das alles andere als einfach ist. Denn je nach gewähltem Raw Konverter kommen, aus ein und derselben Datei, doch ziemlich abweichende Farben hervor.

Deshalb, für den oben genannten Beitrag: Der jeweils vom Fotografen gewählte Raw Konverter bzw. die JPEG Konvertierung, dürfte auf das entwickelte Foto im Endeffekt eine viel größere Rolle spielen als der Heinzelmann Effekt.

Der Schlüssel

zu (möglichst) perfekten Farben ist eine perfekte Belichtung – unter besonderer Beachtung der Kontrastwerte; und ein optimaler Weißabgleich – nicht allein nach Kelvin-Werten, sondern auch unter Beachtung davon abweichender Farbanteile, also manuell vor Ort oder über das RAW-Bild.

Das ist nicht wirklich perfekt – siehe Bayer-Sensor ff oder auch die Jpeg-Konvertierung – aber erlaubt auch unter diesen Bedingungen eine höchstmögliche Annäherung ans Ideal.

P.S. Und Plaubel hat auch recht, irgendwie. 😉

Objektiv richtige Farben

[quote=Gast]Und da ist mir aufgefallen, dass das alles andere als einfach ist. Denn je nach gewähltem Raw Konverter kommen, aus ein und derselben Datei, doch ziemlich abweichende Farben hervor. [/quote]

Und bei gleichem RAW-Konverter gibt es bei ansonsten identischen Einstellungen noch unterschiedliche Farben je nach Kamera/Farbprofil. Objektiv richtige Farben sind ein schwieriges Thema. Wer mag, der kann sich ein Farbprofil selbst erstellen, aber auch das ist nicht trivial. Insoweit ist’s letztlich doch eine Frage der persönlichen Beurteilung, was “richtig” aussieht nach den persönlichen Kriterien.

Doppelter Irrtum, alter Hut

[quote=Gast]der demonstrierte Heinzelmann Effekt ist ja für sich genommen schom mal sehr interessant und ich bin auf den zweiten Teil gespannt.

Was mich beschäftigt ist, dass ich (mache Naturfotos) eine möglichst naturnahme Farbwiedergabe bevorzuge. Und da ist mir aufgefallen, dass das alles andere als einfach ist. Denn je nach gewähltem Raw Konverter kommen, aus ein und derselben Datei, doch ziemlich abweichende Farben hervor.

Deshalb, für den oben genannten Beitrag: Der jeweils vom Fotografen gewählte Raw Konverter bzw. die JPEG Konvertierung, dürfte auf das entwickelte Foto im Endeffekt eine viel größere Rolle spielen als der Heinzelmann Effekt.[/quote]

Nein, weder spielt der Konverter eine Rolle noch eine Konvertierung. Das hat alles nichts mit Farben zu tun, die man selbst festlegen muss.

Es gibt auch keine “naturnahe Farbwiedergabe”, sondern nur die, die Sie zulassen.

Sie haben explizite Erkenntnis-Defizite was Farbkontrolle angeht, darum enthält jeder Satz von Ihnen einen Irrtum.

Gut Licht!

Der Pilz ist ein Kauz.

Das Zitat von Goethe ist nicht paradox, sondern eine Inversion zur Betonung einer Alliteration.

Farben existieren nicht.

Plaubel schrieb:

Der Pilz

[quote=Plaubel]Der Pilz ist ein Kauz. .[/quote]

Hehe, das ist echt lustig, jetzt, wo du es sagst, sehe ich es auch.

Vielleicht hätte der kollege doch besser eine längere brennweite verwendet, dann hätte ich das auch sofort gesehen. Ohne 400% vergrösserung vom bösen bayer sensor. 🙂

Das

“Mit höheren Auflösungen geht zwangsläufig eine Vervielfachung der Mikrostrukturen einher. Einerseits werden mehr Details darstellbar, andererseits bewirkt der Heinzelmann-Effekt, dass über alle Kameratypen und -modelle hinweg wichtige Bildinformationen einfach im digitalen Bermuda-Dreieck verschwinden.”

wäre allein für sich die perfekte Beschreibung für Beugungseffekte …

Und??

Ich habe gerade für eine Geburtstagsfeier ein kleines Fotobüchlein erstellt, wo auch ein paar Bilder, aufgenommen mit einer 1,3 MP Kodak/Canon EOS1n/DCS3 ihren Weg rein fanden… Oder ein weiteres Buch für den Eigengebrauch, fotografiert mit einer aktuellen APS-C und einer Vollformat DSLR sowie ein paar Bilder einer Bridgekamera von 2012. Mich „stören“ weder die Farben des Vor-1997-Uralt-Kodaksensors, noch die der jungen Kameras. Klar, dass man beim alten Sensor etwas mehr „arbeiten“ muss, und dass Bilder aus Bridge bis DSLR nebeneinander bei 1:1/100% Pixelmonitorwiedergabe ihre Herkunft zeigen. Aber wen schert das im Fotobuch, ja selbst in A3+ auf Papier?

Der Heinzelmännchen-Beitrag erweckt den Eindruck für Ken Rockwells Equipment Measurbator(s): Bottom Level 1 http://www.kenrockwell.com/tech/7.htm geschrieben worden zu sein. „Abbild(n)er“ – nicht mal als Amateurfotografen kann man sie bezeichnen -, die IMMER die aktuellste Kamera und das schärfste Objektiv haben, die ihre Bilder aber offensichtlich ausschließlich auf Monitoren betrachten. Papier ist ja auch so was von altmodisch. Und sich daran ergötzen, jenseits der 100% bei 2/400% Monitordarstellung endlich, ENDLICH ein paar Abbildungs-/Farbfehler zu finden. Nein, ist das spannend… Ich zittere schon vor Aufregung, wenn ich an die Fortsetzung denke…

Das Spannende

sind nicht die 400% , sondern die Erkenntnis, dass sichtbare Mängel in der Bilddarstellung – der Farb- und Kontrastwiedergabe – offensichtlich schon (aber nicht ganz unbekannter Weise …) auf Pixelebene ihren Ausgang nehmen. Die Schlussfolgerungen des Autors erwarte ich mir aus dem angekündigten 2. Teil, und dann erst erlaube ich mir ein verbindliches Urteil über die Qualität des Beitrags.

Namensgebung

Frag mich nur was ein Rekonstruktionsartefakt und gewolltem (!) Anti-Aliasing-Effekt mit einem Geist mit Zipfelmütze, der Hausarbeiten verrichtet, zu tun hat…

[quote=Wikipedia]

Die Heinzelmännchen waren der Sage nach Kölner Hausgeister. Sie verrichteten nachts, wenn die Bürger schliefen, deren Arbeit. Da sie dabei jedoch beobachtet wurden, verschwanden sie für immer. Neben ihrer Kleinheit zeigen auch typische Attribute, wie die Zipfelmütze und ihr Fleiß, dass die Heinzelmännchen zur Gruppe der Kobolde, Wichtel und Zwerge gehören.

[/quote]

http://de.wikipedia.org/wiki/Heinzelm%C3%A4nnchen

Die Zipfelmütze

hatten sie in der bewußten Nacht, als sie beobachtet wurden, wohl abgelegt … jetzt schämen sie sich. 😎

Eines ist von vorneherein klar in dem Beitrag!

Nikon schneidet wieder mal am besten ab, was sonst?

Was sonst

[quote=Gast]Nikon schneidet wieder mal am besten ab, was sonst?[/quote]

ist Ihnen nicht gsnz klar in diesem Beitrag …? 😎

Glück gehabt.

War ja auch kein Foveon Sensor dabei.

Dank Konsumtrotteln wie Dir…

[quote=Gast]Nikon schneidet wieder mal am besten ab, was sonst?[/quote]

…und Dank Sony-Sensoren!

Sudel Eddi.

Den Klugen brummt der Kopf, den Dummen brummt der Hintern.

für die Praxis des Fotografierens unnötige Theorie.

Linien- und Pixelzählen hat heute ohnehin überhand genommen – häufig ohne wirklich brauchbare Aussagen für die Praxis zu gewinnen. Das braucht man nicht auch noch zusätzlich zu verbreiten.

Statt Theorie: fotografieren gehen. Das schult das Sehen und Erkennen, ganz ohne Pixelkraxeleien.

Genau

Statt Mängel aufzeigen, lieber blöd die Kassen füllen … das macht den liebenswerten Konsumtrottel aus. 😎

Unnötig

sind nur Kommentare, die sich der Unnötigkeit von Erkenntnisgewinn versichern.

Der Beitrag ist jetzt 12

Der Beitrag ist jetzt 12 Stunden online, Zeit auf den einen oder anderen Kommentar einzugehen. Am besten fange ich gleich mit dem Ersten an:

“Was heißt das jetzt? Dass man (mehr-) farbige Motive mit Farbsensoren fotografieren sollte? Oder doch mit einer monochromen Leica? Oder dass eine 3000 Euro teure D800E bei bestimmten Motiven genau so für die Würscht ist wie eine 300 Euro APS-C Kamera von vor 7 Jahren? Oder nur dann, wenn man die Bilder in Farbe und schwarz aufsplittert?”

Ja genau das trifft es. Es wäre bestimmt interessant mit einem monochromen Sensor und Rot-,Grün- und Blaufilter zu belichten, um dann die Separationen zu einem RGB-Bild zusammen zufügen und das Ergebnis mit einem herkömmlichen Ergebnis zu vergleichen. Vielleicht hat ja jemand die Mittel und die Muse dazu und stellt uns da Ergebnis zur Verfügung.

Der Vergleich mit der D800E und den APS-C Kameras zeigte den gleichen Effekt.

Den Hinweis auf den “Pilz” finde ich sehr gelungen und Plaubel erkennt tatsächlich einen Kauz, der auf diese große Distanz mit bloßen Auge auch zu erkennen war und mangels Tele einfach so belichtet wurde. Ist es nicht erstaunlich, daß sich aus dieser geringen Pixelmenge eindeutig ein Kauz und eben kein Pilz oder dgl. hochzoomen läßt? Es ist also ganz entscheidend, wie die Mikrostrukturen erfaßt werden. Beim Kauz hat es halt gepaßt, in anderen Bereichen reicht es evtl. nur noch zu Pixelbrei.

“Was will uns der Künstler jetzt damit sagen? Das es bei der Demosaizierung des Bayer Patterns Artefakte gibt? Das das JPEG-Kompressionsverfahren Artefakte hervorruft? Dass Wasser naß ist? ”

Ja das Wasser ist naß, aber manchmal ist es etwas nasser und wenn die kleinen Kobolde die Pixel ganz systematisch aufhäufen, mögen sie wohl etwas anderes im Schilde führen, als Artefakte herbei zu zaubern. Auch sonstige Artefakte stehen nicht im Zentrum der Betrachtung.

“Der Hauptgrund ist wohl im “superdemokratischen” Medium Digitalfotografie an sich zu suchen. Wobei hier ein offensichtliches Missverständnis zwischen Verbindlichkeit und Beliebigkeit vorliegt. Und das Konstrukt der Sensoren, wie auch die Struktur der Datenverarbeitung fördert diese Herangehensweise nachhaltig. Das war und ist halt auf Film nicht oder nicht in diesem Umfang möglich – was aber nicht zum Irrtum verleiten sollte, dass da noch alles gut oder gar besser war.”

Genau – nicht besser, aber authentischer!

“Der jeweils vom Fotografen gewählte Raw Konverter bzw. die JPEG Konvertierung, dürfte auf das entwickelte Foto im Endeffekt eine viel größere Rolle spielen als der Heinzelmann Effekt.”

Sicher hat die Konvertierungspraxis einen entscheidenden Einfluß auf das Ergebnis. Die isoluminanten Farbverschiebungen, die hier beschrieben werden, finden jedoch unabhängig davon statt und sind auch (leider) nicht beeinflussbar.

“Eine korrekte Belichtung “bildwichtiger Teile” (individuell festgelegt) ist der richtige Weg aus technischer Sicht.”

Sehe ich auch so – nur läßt sich dadurch die isoluminante Farbverschiebung auch nicht beeinflussen.

“Ein Weißabgleich ist – im Rahmen der technischen Bedingungen – objektiv. Und wenigstens richtungweisend. Und dass eine korrekte Belichtung nachhaltigen Einfluss auf eine korrekte (korrekt empfundene) Farbwiedergabe hat, das ist schlicht subjektiv verifiziertes – und auch schulisch geteiltes, somit multipliziertes – Erfahrungswissen.”

Da stehe ich voll und ganz dahinter! So manches Anekdötchen ließe sich dazu beitragen, doch wir kämen vom Thema ab.

Das war es für heute Abend. Jetzt mache ich schnell das Licht aus, denn die kleinen Wichtel wollen ungestört ihr Werk vollbringen.

Heiner Muskulus

Ja, genau

“Ja genau das trifft es. Es wäre bestimmt interessant mit einem monochromen Sensor und Rot-,Grün- und Blaufilter zu belichten, um dann die Separationen zu einem RGB-Bild zusammen zufügen und das Ergebnis mit einem herkömmlichen Ergebnis zu vergleichen. Vielleicht hat ja jemand die Mittel und die Muse dazu und stellt uns da Ergebnis zur Verfügung.”

Das war mal im Prinzip der ursprüngliche Ansatz bei einigen wenigen Digitalkameras der frühen Generationen. Und bei Videocams ist er es teilweise immer noch. Und die Ergebnisse können nachhaltig überzeugen, was Auflösung und Farbdifferenzierung betrifft. Ist halt aufwändiger – damit dem kosteneffizienten Mainstream nicht zuträglich.

Es…

…saugt und bläst der Heinzelmann, wo Mutti sonst nur saugen kann…

Wenn, dann musst Du schon richtig zitieren:

Sonst ist der Witz weg:

[quote=Loriot]Es saugt und bläst der Heinzelmann, wo Mutti sonst nur blasen kann…[/quote]

Dieser Bericht…

gerade jetzt ist eine Vorbereitung auf neue Sensoren die wohl in wenigen Monaten auf der Kölner Fotomesse gezeigt werden. Man muss die guten Sensoren langsam madig machen und dann die Heil bringende Lösung präsentieren. Schon läuft der Absatz wieder wie er soll. Anders lässt sich das Betrachten von Bildteilen bei 400% nicht erklären. Das ist ungefähr so logisch wie sich einen Druck mit der Lupe anzusehen und sich gleichzeitig über das Raster zu beschweren.

Über so etwas individuelles wie farbiges Sehen zu diskutieren ist müßig. Nur weil etwas messbar ist muss es noch lange nicht in seiner Gesamtheit stimmig sein.

Für mich ist es ein interessanter Bericht und ich bin auf die Fortsetzung gespannt.

Das sehen Sie

gewiss zu optimistisch … da kommt nix Heilbringendes auf der Photokina. Und das Bayer-Dilemma braucht man auch nicht madig machen, da steckt schon länger der Wurm drin … 😎

Normierung der Vergleichsbilder

Die vergleichende Darstellung der grünen Doppelkreuze sollte besser auf die gleiche maximale Intensität normiert werden. In einer solchen Auftragung wäre der Vorteil der hohen Auflösung, d.h. der dichteren Abtastung, deutlich besser sichtbar. Aus meiner Sicht zeigt der Vergleich dann ein zu erwartendes Ergebnis und liefert keine neuen Erkenntnisse.

P. S.: Lieber Herr Maschke, bitte veröffentlichen Sie in Zukunft nur wissenschaftlich fundierte Artikel von Autoren mit entsprechender Ausbildung. In den letzten Wochen stand hier leider die Esoterik im Mittelpunkt. Als Physiker im Arbeitsgebiet Digitale Bildrekonstruktion kann man bei der zweifelhaften Qualität dieser photoscala-Beiträge nur den Kopf schütteln.

In diesem Fall

rekonstruieren Sie uns doch mal wissenschaftlich fundiert unseren alltäglichen Pixelbrei … bittschön. Aber nur, wenn Sie sich nicht hinter dem esoterischen Kauderwelsch der Wissenschaft verschanzen müssen, sondern Ihre Analyse auch Normalsterblichen verständlich vermitteln können. Dankeschön. 😎

Zustimmung

[quote=Gast]P. S.: Lieber Herr Maschke, bitte veröffentlichen Sie in Zukunft nur wissenschaftlich fundierte Artikel von Autoren mit entsprechender Ausbildung. [/quote]

Der Bitte und Einschätzung möchte ich mich anschliessen.

Foveon

was in der Kameraliste fehlt, wäre der Vergleich mit einem Foveon Sensor, da hier die Farben nicht aus den Nachbarpixeln interpoliert werden müssen.

Stimmt

die müssen insgesamt interpoliert werden. Von oben nach unten …

ich staune

und bin irritiert: So habe ich meine Kamera und das Fotografieren noch nicht betrachtet. Aber wie ist es möglich, damit Aufnahmen zu machen, auf z. B. 60x180cm zu drucken, so dass alle Leute begeistert sind? weil alles scharf genug ist, um klar erkennbar zu sein, auch in kleinsten Details? Es ist ein Bißchen Arbeit und Überlegung vonnöten bei Aufnahme, Entwicklung und Druckvorbereitung, aber das war ja schon immer so! – solange ich fotografiere jedenfalls (seit 35 Jahren). Vielleixht gings vor 300 Jahren ja schneller.

Wer nimmt eigentlich jpg, wenn er richtig gute Bilder vergrößern und drucken oder ausbelichten will? Und das Bild an der Wand ist doch das Ergebnis, bei dem die Fehler erst wirklich sichtbar werden, auf dem Bildschirm ist doch eh alles nicht so wichtig.

Oder?

Ich stsune auch

über die Vergesslichkeit altgedienter Fotografen, die nicht mehr wissen, wie simpel es war, ein Dia zu belichten und in bester Qualität darzustellen. Und wie aufwändig heute Algorithmen auf Sensoraufzeichnungen angewandt werden müssen, mit und ohne Zutun des Fotografen, um (dann erst) in durchaus sehr guten Qualitäten an der Wand zu hängen. Wenn ich den Beitrag nicht ganz falsch verstehe, dann liefert er uns den einen oder anderen Grund (mehr), warum das so ist, und zweifelt nicht so sehr am Endergebnis.

Gibbs’sches Phänomen

Beim hier als “Heinzelmann-Effekt” bezeichneten Verhalten handelt es sich wohl eher um das Gibbs’sche Phänomen (oder auch Ringing). Es benennt in der Mathematik das Verhalten, dass bei der in der Signalverarbeitung (und nicht nur in der .jpg-Komprimierung!) verwendeten Fourier-Transformation von stückweise stetigen, ableitbaren Funktionen in der Umgebung von Sprungstellen so genannte Überschwingungen auftreten. Dies ist eine Eigenschaft der Fourierreihen und lässt sich nicht prinzipiell vermeiden.

MR

Die Überraschung hält sich in Grenzen.

Es gelten dieselben Feststellungen hinsichtlich technischer Ursachen, wie zu den unsäglichen Auslassungen von Chris H.

Doch im Gegensatz hierzu ist dieser Artikel gut zu lesen und sehr anschaulich und liebevoll illustriert (dafür weniger klugscheissernd) – vielen Dank dafür.

Es saugt und bläst der Heinzelmann

wo Mutti sonst nur saugen kann.

– Zitat: Loriot

Den hatten wir schon.

Aber der Witz heißt “blasen”, nicht “saugen”.

Da haben Sie aber

jetzt lang dran gesaugt … 😎

Good morning Vietnam

[quote=Gast]wo Mutti sonst nur saugen kann.

– Zitat: Loriot[/quote]

Zitat: Ich hab noch keinen Typen kennen gelernt, der es so nötig hatte einen geblasen zu bekommen.

…