Dieser Beitrag unternimmt den Versuch, die Belichtung für digitale Aufnahmemedien mit Hilfe des Zonensystems neu zu verstehen und für die praktische Anwendung aufzubereiten, so dass konsistente Bildergebnisse direkt aus der Kamera realisiert werden können. Er soll auch Anregung sein, dass die hier dargestellte Form der Belichtung als Open-Source-Beitrag von jedem Hersteller aufgegriffen werden möge, der diesen Betrachtungen etwas abgewinnen kann:

Dieser Beitrag unternimmt den Versuch, die Belichtung für digitale Aufnahmemedien mit Hilfe des Zonensystems neu zu verstehen und für die praktische Anwendung aufzubereiten, so dass konsistente Bildergebnisse direkt aus der Kamera realisiert werden können. Er soll auch Anregung sein, dass die hier dargestellte Form der Belichtung als Open-Source-Beitrag von jedem Hersteller aufgegriffen werden möge, der diesen Betrachtungen etwas abgewinnen kann:

Es sei vorausgeschickt, dass mir dieser Zugang sehr bei meiner konkreten Arbeit hilft, auch wenn die technischen Voraussetzungen derzeit nur eine näherungsweise Umsetzung erlauben. Aufgezeigt werden soll, wie ein modifiziertes Verständnis des Zonensystems dazu verhelfen kann, die Belichtung von Motiven mit unterschiedlichem Motivkontrast schon bei der Aufnahme so aufzubereiten, dass eine nachträgliche Tonwertkorrektur zur Bildoptimierung, außer für kreative Zwecke, weitgehend entfallen kann; dass also die Digitalfotografie in die Lage versetzt wird, konsistente Bildergebnisse direkt aus der Kamera zu liefern.

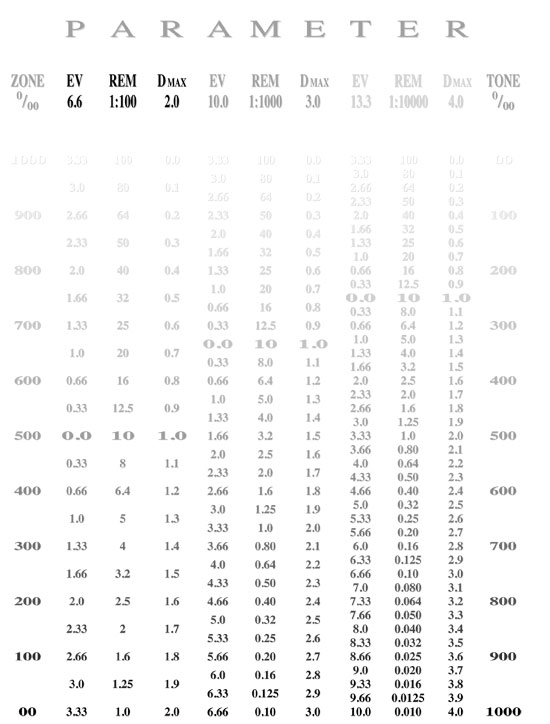

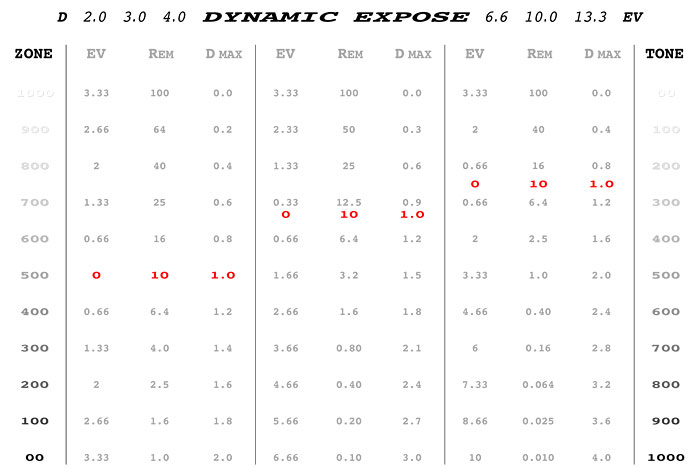

Dazu habe ich eine Tabelle angefertigt, wo mein Zugang exemplarisch dargestellt ist und die weitgehend selbsterklärend für den Betrachter sein sollte. Trotzdem eine „Gebrauchsanweisung“:

Mein Ansatz geht davon aus, das Zonensystem, mit seiner Einteilung von 0 – 10 Belichtungszonen, als grundlegende Skala für die Positionierung von Belichtungswerten bei Motiven mit unterschiedlichem Kontrast zu nutzen. Aber nicht in seiner klassischen Form, schon gar nicht mit lateinischen Zahlenwerten versehen, sondern – resultierend aus der Erkenntnis, dass es sich bei der Zonenskala dem Prinzip nach um nichts anderes als eine umgekehrte Tonwertskala handelt – definiert als Promilleskala von 0 ‰ bis 1000 ‰. Ergänzend dazu findet sich auf der Darstellung eine sich umgekehrt proportional darstellende Tonwertskala, ebenfalls in Promille; passend zu einer anzustrebenden 10-Bit-Ausgabe.

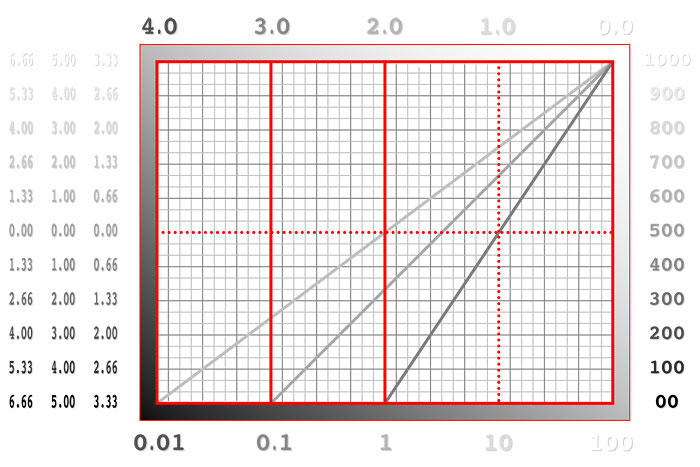

Zwischen diesen beiden Skalen entfalten sich nun die Belichtungswerte von drei exemplarisch ausgewählten Kontrastsituationen, die ich, um möglichst runde Zahlenwerte für die Darstellung zu erhalten, folgendermaßen definiert habe: Die Abstufung erfolgt nach logarithmischen Einheiten, entsprechend einem Motivkontrast von 1:100, 1:1000 und 1:10.000. Als Parameter dafür dienen Lichtwerte im Umfang von 6,6, 10 und 13,3 EV, die messtechnisch relevanten Remissions-Prozentwerte (REM); und die entsprechenden (maximalen) Dichtewerte, entsprechend Dmax 2,0, 3,0 und 4,0. Als Nullwert für den Belichtungsabgleich habe ich nicht das bekannte 18-%-Grau gewählt, sondern ein 10%-iges Grau, entsprechend einem Dichtewert von 1,0 – als tatsächlich mittleres Grau eines Kontrastumfangs von 1:100 (in der Darstellung auch entsprechend herausgehoben).

Die Darstellung der Belichtungsstufen erfolgt in dem ihnen entsprechenden Grauwert (welcher auch als Binärwert einer 10-Bit-Ausgabe lesbar ist). Lichtwerte, Remissions- und Dichtewerte stehen zueinander immer im gleichen Verhältnis, und entfalten sich unter einer gegebenen Kontrastsituation gleichmäßig, logarithmisch abgestuft, entlang der Skalen von Zonen- bzw. Tonwerten: Jeder gleichmäßige Belichtungssprung, in der Tabelle in Drittelstufen dargestellt, nimmt auf den Skalen seinen exakt definierten Platz ein – ist zonen- bzw. tonwertmäßig genau lokalisiert.

Bei höheren Motivkontrasten – hier 1:1000 und 1:10.000 – sehen wir aber, dass sich der „mittlere“ 10-%-Grauwert hin zu helleren Tonwerten, zu höheren Zonenwerten verschiebt – und mit ihm auch alle anderen Tonwerte, mit Ausnahme des reinen Weiß. Was sich logischerweise aus dem Umstand ergibt, dass hier auch ein größerer Umfang an Helligkeitswerten in das vorgegebene Raster der Zonen- und Tonwerte eingefügt werden muss, die Grundanforderung sich aber nicht ändert: Dass sich logarithmisch definierte Belichtungswerte stets im gleichen Abstand zueinander einfügen müssen, um korrekt darstellbar zu sein.

Dies führt nun praktisch dazu, dass sich hohe Kontrastunterschiede eng abgestuft, geringe Kontraste hingegen deutlich abgestuft auf den Referenzskalen abbilden – dass somit der Kontrastumfang nicht nur deutlich abgebildet wird, sondern auch der dafür zur Verfügung stehende Ausgaberaum umfassend optimal genutzt wird (entsprechend einem Histogramm, das sich, unabhängig vom Aufnahmekontrast, stets optimal darstellt). Die Wiedergabe von Bildern nähert sich dadurch weitgehend dem natürlichen Helligkeits-Empfinden des Auges an.

Dies führt nun zu konkreten Schlussfolgerungen bzw. „Regeln“, die sich aus dem Dargestellten ableiten lassen:

- Es ist logisch notwendig, dass bei gleicher Belichtung, aber unterschiedlichem Motivkontrast, die Kontrast„kurven“ angepasst und signalmäßig asymmetrisch verstärkt werden müssen – je höher der Kontrastumfang, desto stärker.

- Die Belichtungsermittlung erfolgt nicht mehr (allein) über einen (mittleren) Referenzwert, sondern leitet sich vorrangig aus dem vom Sensor erfassten Kontrastumfang einer Szenerie ab.

- Die Belichtungsinformation geschieht nicht mehr über eine klassische Lichtwaage, auch nicht über ein komplexes Histogramm, sondern der Fotograf bekommt über eine „Zonenwaage“ die Information vermittelt, welchen Tonwertumfang sein Motiv belegt, bzw. welchem Tonwert ein angemessenes Motivdetail entspricht. Eine Kontrasteinstellung als zusätzlicher, kreativ nutzbarer Belichtungsparameter erscheint wünschenswert.

- Belichtungstechnisch ermöglicht das Zonensystem exakt definierte Belichtungsänderungen, abhängig vom vorhandenen (oder auch wählbaren) Motivkontrast; da jeweils ein 100-‰-Sprung auf der Zonenskala genau 1/10 des Gesamtmotivkontrasts, somit des Belichtungsumfangs, entspricht.

- Die notwendige Belichtungsanhebung ist mathematisch exakt definiert: Entspricht ein 10-%-Grauwert bei einem Kontrast von 1:100 einem Zonenwert von 500 ‰, so gilt bei einem Kontrast von 1:1000 ein 666-‰-Zonenwert. Seine Position liegt demnach, bezogen auf den Belichtungsumfang von 10 Belichtungsstufen, 16,6 % höher. Eine Signalverstärkung entspricht genau diesem Prozentsatz, umfasst also konkret 1,66 Lichtwerte. Diese Regel gilt, ausgehend vom geringst darstellbaren Kontrastumfang, für alle darzustellenden Belichtungswerte und ist entsprechend anzuwenden.

- Sollte der Kontrastumfang eines Motivs das Aufzeichnungsvermögen des Sensors übersteigen, so lässt sich das Zonen-Prinzip auch auf eine dann notwendige HDR-Belichtung anwenden.

- Der letztliche Ausgabekontrast hat keinen unmittelbaren Einfluss auf die Positionierung der Lichtwerte auf der Zonenskala; weswegen die Zonenskala auch nicht belichtungstechnisch relevant ist, sondern einfach einen Referenzmaßstab dafür liefert, mit welchem Tonwert ein bestimmter Belichtungswert (im Ausgabemedium) darzustellen ist.

- Bezüglich der Farbdarstellung gelten die gleichen Zonen-Regeln: Es wird also jeder Farbwert, ausgehend vom Motivkontrast, exakt auf der Zonenskale verortet und damit in seiner Farb(ton)darstellung genau festgelegt.

- Eine zumindest 10-Bit-Ausgabe wäre im Hinblick auf eine genauere Darstellung auch kontrastreicher Motive möglichst anzustreben, der gültige 8-Bit-JPEG-Standard grundsätzlich zu hinterfragen.

- Es drängt sich der zwingende Verdacht auf, dass ein solches Verständnis von Belichtung auch entsprechende Auswirkungen auf die Funktion von Belichtungsautomatiken haben muss.

Argumente und Schlussfolgerungen

Mein Ansatz soll nicht nur das Fotografieren mit der Digitalkamera vereinfachen, sondern, durch weitgehenden Entfall der Notwendigkeit nachträglicher Tonwertkorrektur, auch Arbeitserleichterung und Zeitersparnis bringen. Und er soll dazu verhelfen, dass ein gegebener Belichtungsumfang exakt (!) im darstellbaren Tonwertspektrum verortet wird – dadurch aber auch kontrolliert(er) und besser nachvollziehbar manipulierbar wird, wenn dies gewünscht ist. Die Zonen- bzw. Tonwertskala – in meinem Zugang ja nur zwei gegenläufige Betrachtungsarten des Themas – geben die Struktur vor, in die sich ein Motiv mit gegebenen Kontrastumfang natürlich und, vor allem, gesetzmäßig (!) einfügt.

Es geht nicht um ein (nachträgliches) Manipulieren der Kontrastkurve, vielmehr variiert die Aufzeichnung des Motivkontrasts schon seines Umfangs wegen zwischen:

- STEIL, wenn es sich um ein kontrastarmes Motiv handelt, dessen geringe Kontraste dadurch besser herausgearbeitet werden

- NORMAL, wenn der Motivkontrast mit dem Ausgabeumfang übereinstimmt (der vom Ausgabemedium 8-Bit-JPEG bestimmt wird, aber idealer Weise möglichst auf ein mindestens 10-Bit-Niveau gehoben werden sollte)

- FLACH, wenn Motive mit hohem Kontrast für ein begrenztes Ausgabemedium aufbereitet werden müssen (vergleichbar einer HDR-Ausgabe)

Verschiedene Methoden der Anwendung sind denkbar:

- Der Kontrastumfang eines Motivs wird automatisch registriert und für eine korrekte Ausgabe automatisch aufbereitet.

- Der Ausgabekontrast wird mit Hilfe einer „Tonwertwaage“ manuell eingestellt, die Auskunft über den hellsten, den dunkelsten und einen angemessenen Tonwert gibt; an den Motivkontrast angepasst.

- Der Ausgabekontrast wird nach Belieben gewählt – Abweichungen vom konkreten Motivkontrast können kreativ genutzt werden.

- In der Bildbearbeitung kann der Bildkontrast – nachvollziehbar – innerhalb der Darstellungsbreite variiert werden.

Diese Form der Kontrastbeeinflussung unterscheidet sich von bisher vorgegebenen Werkzeugen bzw. Einstellungen hauptsächlich dadurch, dass hier der Kontrast mit konkreten Werten, in reproduzierbaren Abstufungen beeinflusst werden kann – dass die Kontrasteinstellung als ein zusätzlicher, die Bildausgabe wesentlich bestimmender, Belichtungsparameter neu definiert wird.

Interessant wäre es, den Motivkontrast als EV-Stufen vorzugeben. Gleichzeitig erscheint es auch sinnvoll, die bisherigen, aus Filmzeiten übernommenen ISO-Werte neu als EV-Verstärkungsstufen, ausgehend von einem genormten Basiswert (entsprechend ISO 100) zu definieren. Dadurch wird es möglich, die Kontrast- und Belichtungsparameter in ihrer wechselseitigen Abhängigkeit zueinander darzustellen und wahrzunehmen

Dadurch, dass der Aufnahmesensor selbst zur Belichtungsmessung und -steuerung herangezogen wird, entfallen künftig mehr oder weniger aufwändige Messmodule, einschließlich unterschiedlicher Messmethoden. Allenfalls könnte ein, ebenfalls über den Sensor gesteuerter Autofokus mit selektiven Messfeldern dafür sorgen, für definierte AF-Bereiche auch eine konkrete Tonwertinformation zu liefern.

Evident scheint auch das Ende der herkömmlichen SLR-Technologie zu sein, lässt sich doch beim Spiegelreflex-Prinzip der Sensor selbst nicht zur Belichtungs- und AF-Steuerung verwenden. Da aber der Entfall eines optischen Suchers eine Verarmung der Fotografie bedeutete, wäre eine Alternative, den Schwingspiegel durch einen starren Spiegel oder ein Teilerprisma zu ersetzen.

Für eine automatische Belichtungssteuerung ist es entscheidend, dass unterschiedliche Motivkontraste nicht einheitlich aufbereitet werden – was das Versagen von Automatiken hauptsächlich begründet –, sondern dass unterschiedliche Kontraste auch unterschiedliche Bewertung erfahren, und dass eben nicht ein „durchschnittlicher Grauwert“ allein (der nur zur Erfassung einer Grundhelligkeit, damit zum eigentlichen Belichtungsabgleich, nötig ist) für eine korrekte Belichtung sorgen kann, sondern dass ein Motiv in seiner gesamten Helligkeitsstruktur erfasst und korrekt umgesetzt werden muss.

Genau das ermöglicht die Digitalfotografie – weil das Aufnahmemedium gleichzeitig auch „misst“ (eigentlich Photonen zählt) und damit befähigt wird, Motive nicht allein in ihrer „durchschnittlichen“ Helligkeit zu erfassen, sondern aus einer Analyse heraus auch korrekte Darstellungen abzuleiten vermag – wenn die Vorgabe passt. Weil das aber im Moment nicht so erfolgt – allenfalls automatisierte Ansätze dazu in die Kameras verbaut werden (zuschaltbare Kontrast- oder Tonwertkorrekturen) –, war es mir ein Anliegen, dieses (irgendwie leidige) Thema gründlich zu analysieren, und mit einer freien Interpretation des Zonensystems eine, wie ich glaube, gültige Aussage treffen zu können.

Nebenbei hat sich damit (für mich) auch die Frage danach beantwortet, warum wir so sehen (können) wie wir (so abweichend von digitaler Aufzeichnungstechnik) halt sehen: Weil auch unsere Augen letztlich nichts anderes als Photonenzähler sind – die aber nicht einer linearen Interpretation unterliegen (wenig ist nichts, mehr ist besser, und viel mehr ist viel, viel besser), sondern die die richtigen Schlüsse aus den Differenzen der Photonenmengen zu ziehen vermögen (mehr ist mehr, und weniger ist weniger – aber stets im proportionalen Maß).

Letztlich auch eine philosophische Frage … 😉

(Christian Herzenberger)

Also

erstmal freue ich mich über jeden intelligenten, selbstverfassten Artikel auf photoscala. Allerdings ist mir der Sinn dieses Artikels nicht ganz klar geworden:

Warum 10 Bit/Blendenstufen?

-> Meine Kamera hat waschechte 12,5 Blendenstufen Dynamikumfang (kein Werbeblahblah, kein DxO).

-> Mein Monitor hat lt. I1 Pro einen Kontrastumfang von 1:238, also knapp 8 Blendenstufen.

-> Mein Fotopapier kommt auf 5-6 Blendenstufen.

Warum also 10 Blendenstufen?

Warum den Belichtunsgumfang mit Tabellen präzise abzirkeln, wenn ich das Ergebnis eh hinterher auf 5-8 Blendenstufen zusammenquetschen muss — bzw. strecke, um das Bild zum Leuchten zu bringen?

Übrigens: [quote]“Gleichzeitig erscheint es auch sinnvoll, die bisherigen, aus Filmzeiten übernommenen ISO-Werte neu als EV-Verstärkungsstufen, ausgehend von einem genormten Basiswert (entsprechend ISO 100) zu definieren.” [/quote]ist ein uralter Hut, der im Laufe der amerikanischen Digitalisierung des Aufnahmemediums verloren gegangen ist: Früher wurden (in Deutschland zumindest) die Filmempfindlichkeiten in DIN angegeben, wobei 3 DIN einer — in Ihrer Ausdrucksweise — “EV-Verstärkerstufe” von einem Faktor zwei entsprach. Also: 100 ASA/ISO (ASA: American Standards Association, ISO: International Standards Organization) = 21 DIN (Deutsche Industrie Norm). 200 ASA = 24 DIN, 800 ASA = 27 DIN, 1600 ASA = 30 DIN, 3200 ASA = 33 DIN, etc.

Also

wenn ich’s nicht ganz falsch verstanden habe, geht’s darum, Aufnahmekontraste und Ausgabedarstellungen in Einklang zu bringen. Die 10 Bit habe ich eher als Mindestmaß gelesen – und sie harmonieren erstaunlich gut mit der Zoneneinteilung. Für das Prinzip der Zonierung ist es aber letztlich egal, auf wieviele Bit der Aufnahmekontrast, der nicht unbedingt ident mit dem Aufzeichnungsvermögen der Kamera ist, umgemodelt wird, sondern es werden nur die Tonwerte eines Motivs genau festgelegt, und auf jedem Ausgabeformat proportional gleich dargestellt. Und was ASA oder DIN anbelangt, so scheint der Autor einfach den Umgang mit Lichtwerten zu bevorzugen.

Lieber Gast

Erstens freut es mich, dass Sie sich die Lektüre nicht erspart haben … 😉

Zweitens muss ich Ihnen absolut Recht geben, wenn Sie die Vielzahl unterschiedlicher Kontrastumfänge bei digitalen Aufnahme- und Wiedergabemedien betonen – gleichzeitig war und ist es das Anliegen meines Beitrags, Ordnung in diese Vielfalt zu bekommen.

Zu den 10 Bit: Ich habe ich diese 10 Bit aus letztlich drei Gründen gewählt: 1. brauche ich einen zahlenmäßigen Wert, der aktuell durch die 8-Bit-Jpegs vorgegeben ist – und durchaus auch hier brauchbar wäre. Allerdings, und damit 2. keine so klare Darstellung meiner Überlegungen ermöglicht – hier sind 10 Bit, also 1024 Zählewerte, einfach unschlagbar, wenn man sie 1000 “Zonenwerten” gegenüber stellt … und letztlich, 3. ist die 10-Bit-Ausgabe eine durchaus übliche bei Video.

Wichtig aber vor allem ist die Erkenntnis, dass dieses zonenmäßige Erfassen eines gegebenen Kontrasts unabhängig vom Vermögen des Aufnahmegeräts, genauso wie vom Ausgabemedium erfolgt: Wenn Sie bspw. einen Aufnahmekontrast von 12,5 EV auf einem Monitor mit einem Kontrast von 8 EV ausgeben, dann tut die Skala nichts anderes, als die Tonwerte der Aufnahme für die Ausgabe zu transponieren. Mit 10-Bit-Quantifizierung halt genauer, als mit 8-Bit – mit noch mehr Bits halt noch genauer … die Positionierung der Tonwerte ist dabei NICHT von der Auflösung abhängig, auch nicht von den Aufnahme- und Ausgabegeräten, sondern ergibt sich allein aus dem konkreten Kontrastumfang des MOTIVS.

Zu den ISO noch: Ich bin kein besonderer Freund der alten Film-Werte, weder ASA noch DIN. Da ich auch beim Kontrast in Lichtwerten rechne – und meine Überlegungen sehr ans Thema Signalverstärkung gebunden sind – erschiene es mir in diesem Zusammenhang einfach sinnvoll, auch die die Empfindlichkeits-Verstärkungen des Sensors in Lichtwerten zu fassen; also mehr eine pragmatische Herangehensweise, denn Ideologie …

Genauigkeit in der

Genauigkeit in der Fotografie – davon lasst ab.

Denn um Eure Empfindungen sollt ihr euch kümmern nicht um die Methoden. Das Lebendige sollt ihr sehen. Die die da mit euch sind sollt ihr erkennen. Denn siehe, es ist noch immer ein Bild entstanden.

So spricht Plaubel: Nur jene Bilder, die ihr NICHT geplant und konstruiert habt, die ihr nicht begreifen könnt, erhöhen Eure Seele. Und wahrlich, ich sage euch: Euer Leben soll in euren Bildern sein nicht euer Hochmut.

Danke

für die Erläuterungen. Aber was ich sagen wollte, war eigentlich das, was Plaubel weiter unten wunderbar poetisch formuliert hat.

Fotografie, insbesondere Digitale, basiert zwar auf Wissenschaft, ja, da stecken gar mehrere Nobelpreise drin — wenn es aber ums Fotografieren geht, dann interessiert mich die Anzahl der Bits soviel wie bei einem vollen Tank die Anzahl der Tankstellen auf den nächsten 2 km. Am Ende zählt, dass ich ankomme, d.h. dass das Bild Emotionen überbringt. Das können beschnittene 2 Bit sein (Silhouette/Scherenschnitt) oder gestauchte 12 oder gar 32 bit (HDR).

Und auch als Wissenschaftler verlasse ich mich nicht auf dokumentierte/tabellierte Werte, sondern auf im aktuellen Experiment gemessene Verstärkerfaktoren, um z.B. bereichs-, geräte- und temperaturabhängige Abweichungen der theoretischen Verstärkerfaktoren korrigieren zu können. 😉

Ich bin mir

keineswegs 100%ig sicher, dass es keinen Zusammenhang geben kann – und ich begrüße auch Canons neuen Ansatz dazu ausdrücklich.

Aber, für die Funktionsfähigkeit des AF bringt es meiner Meinung nach nichts, wie die Kontraste eines Motivs für die Belichtung hinsichtlich ihrer Tonwerte bewertet werden; muss ein AF doch “nur” darauf ausgelegt sein, Kontraste im Motiv, schon VOR der Belichtung, deutlich zu erkennen, und danach scharf zu stellen. Die zusätzliche Phasenerkennung beschleunigt und perfektioniert diesen Prozess – ist aber wiederum nicht belichtungsrelevant …

Eine Lochkamera

ist in sich perfekt – wenn man Bilder aus einer Lochkamera haben möchte … 😉

Hinter jeder Technologie steht eine Theorie – die sich als mehr oder weniger brauchbar erweist. Mein Anliegen besteht allein in der Frage, ob mein gedanklicher Ansatz nicht vielleicht brauchbar(er) wäre.

Der Vergleich hinkt

[quote=chris h][quote=Gast]Fotowand hat wunderbare grau-und graustufenkarten. Habe noch wenig digitalerfahrung, aber es wundert mich dass es viele kontrastprobleme gibt/ueberstrahlungen trotz 12.5 blenden-umfang.

Ich weiss allerdings dass anpassung von konstrast/farbsättigung(auch einzelner farben) sowie belichtung grossen einfluss aufs bildresultat hat.

sehr interessanter artikel. ich habe zonensystemerfahrung.[/quote]

12,5 Blenden Kontrastumfang … das bringt’s übrigens schön auf den Punkt: Dass sich nämlich der Motivkontrast selten deckungsgleich mit dem Kamerakontrast(vermögen) erweist.

Eine Erfahrung, die mir beinahe meine erste 1Ds vergällt hätte – und mich schnell auch zum “Profi” in der Bildbearbeitung mutieren hat lassen.

Bestürzend, für Manche, auch die Erkenntnis, dass die Ergebnisse aus Kompaktkameras auf Anhieb oft besser wirken (!), als das, was aus der Profikamera tropft.

Aber nicht so verwunderlich für Jene, die um die häufige Kohärenz des Kontrastumfangs bei Kompaktkameras mit dem Motivkontrast wissen.[/quote]

Fotografie ist mehr als ein Sensor. Dieses Mantra sollte man sich merken.

Ich habe vor 20 Jahren eine Kompaktkamera in den Händen gehalten und ich weiss, warum ich heute mit einer (D)SLR fotografiere.

Hier geht es nicht um theoretische technische Betrachtungen.

Und ja: Das schnelle Bildchen aus der Knipse imponiert noch immer vielen Leuten. Das hängt mit der unkritischen Sichtweise auf ein unkritisches Motiv und unkritisches Arbeiten zusammen.

Mag sein

dass wir ein wenig aneinander vorbei reden …

Mit einer Anpassung des Gamma meine ich einen tatsächlich anderen Kontrastverlauf (wie oben dargestellt); aber vielleicht noch dahingehend ergänzt, dass hier bei einem geringen Kontrastumfang nichts “abgeschnitten” wird – die RAW-Daten sind davon auch nicht tangiert, das Motiv wird stets im vollen Kontrastvermögen des Sensors erfasst, die Rechenbasis ist und bleibt auch so hoch, wie sinnvoll nötig – sondern dass hier einfach Voreinstellungen realisiert werden, die der Fotograf dann direkt übernehmen kann (Arbeitserleichterung), aber keineswegs muss (im Sinne kreativer Nutzung). Was dabei wichtig ist: Je nach Kontrast variieren die Tonwerte der Ausgabe, bei gleicher Belichtung, gesetzmäßig (der Kern obiger Darstellungen) – und dies sollte in weiterer Folge auch zu konsistenteren Automatik-Ergebnissen führen (wenigstens im Sinne einer möglichst objektiven Aufbereitung – subjektive Belange mal außen vor).

Eine Tonwertwaage wäre die natürliche Ergänzung eines solchen Zugangs zum Thema Belichtung; wäre sie doch in der Lage, auf einen Blick den Tonwertumfang des Motivs darzustellen – und, bei Bedarf, auch korrigierend einzugreifen (ein zusätzlicher, selektiver Messwert ist dabei durchaus wünschenswert – setzt aber voraus, dass das Motiv auch tonwertrichtig interpretiert wird); was aber nur dann möglich ist, wenn man den Kontrast als vollwertigen Belichtungsparameter (neben ISO, Zeit und Blende) implementiert (dewegen auch mein Anliegen, ISO und Kontrast, leicht verständlich, in EV-Stufen zugänglich zu machen).

Äh

wenn wir Bilder aus der Kamera als flau empfinden (bei DSLRs häufig der Fall) dann liegt das nicht daran, dass die Kamera den Kontrast “heruntergedreht” hat, sondern weil der Kontrastumfang der Kamera (so um die 12 Blendenstufen herum) kontrastärmere Motive (also die meisten) einfach flau wirken läßt … aber dafür gibt’s ja dann das Allheilmittel Photoshop – der macht’s wieder gut. 😎

chris h schrieb:

Aber,

[quote=chris h]Aber, nein, diese Meinung vertrete ich nicht nur gegenüber Nikons Zugang.[/quote]

War auch nur explemplarisch gemeint, um zu zeigen, daß es sich die Hersteller keineswegs so einfach machen mit der Belichtungsmessung, wie du es oben unterstellt hattest.

Mir persönlich fehlt noch der Zugang zu deiner Lösung, obwohl (oder weil?) ich beruflich mit ähnlichen Themen in der Messtechnik beschäftige. In meinen Augen löst deine Methode das falsche Problem, auf eine unnötig komplizierte Weise.

Aber jeder, wie er mag. Für dich funktioniert dein persönliches Zonensystem, und nur darum geht es.

Geister

[quote=Gast]ist ja auch so viel besser ins x-te Motivprogramm, den nächstbesten Smartfilter und das letztklassigste Gimmick investiert – oder gleich nach Wolkenkuckucksheim ausgelagert – als in eine stimmige Aufnahmetechnik auch nur einen Hauch von Kreativität zu stecken … 8-)[/quote]

Wissen Sie, es gibt Leute, die fotografieren – und es gibt Leute, die reden drüber. 🙂

Dann gibt es Leute, die Probleme damit haben, dass es so einfach geworden ist, Bilder aufzunehmen. Dann gibt es da aber auch noch andere Leute, die so kreativ sind zu begreifen, diese neue, bessere Technik zu nutzen – für ihre Bilder, nicht für technische Betrachtungen darüber, wie man Bilder vor langer Zeit mal gemacht hat.

Sie versuchen wie der andere Kollege, etwas zu konstruieren, wobei SIE den rhetorischen Trick bemühen, die neue Technik zu diffamieren, was Ihrer Argumentation dient.

Es geht einfach nur um eine Diskussion der Diskussion willen – damit sind wir da, woran Fotolaien-foren seit Jahren kranken: An sinnlosen Disputen um nicht gemachte Bilder”.

Gut Licht!

Mein Beitrag richtet sich

in erster Linie an Interessierte, in zweiter Linie an “Jemanden”, der sachlich, fachlich in der Lage wäre, diese Überlegungen in eine – so oder auch anders geartete – Realität über zu führen.

Filme vermochten in der Tat das zu leisten, was ich der Digitalfotografie mitgeben möchte – nur halt auf den ihnen eigenen Kontrastumfang, ihre Empfindlichkeit, fixiert: Den Kontrastumfang als Variable, als Ergänzung zur hier längst obligatorischen Empfindlichkeits-Einstellung.

Sie haben es noch nicht verstanden

[quote=Gast]wenn wir Bilder aus der Kamera als flau empfinden (bei DSLRs häufig der Fall) dann liegt das nicht daran, dass die Kamera den Kontrast “heruntergedreht” hat, sondern weil der Kontrastumfang der Kamera (so um die 12 Blendenstufen herum) kontrastärmere Motive (also die meisten) einfach flau wirken läßt … aber dafür gibt’s ja dann das Allheilmittel Photoshop – der macht’s wieder gut. 8-)[/quote]

Ich stelle mir gerade Ihre Reaktion vor 30 Jahren vor: Da hätten Sie bestimmt über die chemische Laborarbeit abgeätzt.

Photoshop hat mit der Vorbearbeitung der RAWs NICHTS zu tun. Begreifen Sie das doch bitte endlich. Weil, wenn Sie das täten, würden Sie nicht so gegen die Maschinen stürmen und unzutreffende Dinge schreiben.

Gut Licht!

Bemüht

[quote=chris h]vielleicht so ähnlich – oder auch nicht, wenn ich mir die eher bemühten Tools für eine bessere Tonwertkontrolle so anschau. Für mich besteht kein Widerspruch darin, einen (notwendigen) Workflow konsistent(er) zu gestalten – auch im Wissen darum, dass er nur dort voll zur Geltung kommt, wo er auch praktisch voll genutzt wird (werden kann).[/quote]

Tonwerte lassen sich einfach kontrollieren. Dazu reicht ein Programm. Das ist nicht bemüht, sondern business as usual.

Man muss natürlich eine gewisse fachliche Bildung besitzen und ein gewisses Equipment – sonst wird das nichts. Das ist heute prinzipiell nicht anders als früher.

Gut Licht!

Sie scheinen sich

eher zu manischen Denkverboten hingezogen zu fühlen. Irgendwann mal über das Zonensystem gestolpert, haben Sie’s offensichtlich nicht verstanden, und es als unbrauchbar geistig verabschiedet. Um, Jahrzehnte später, auf’s Stichwort sich provoziert zu fühlen – und dabei noch nicht mal zu merken, dass es um’s Zonensystem im engeren Sinn gar nicht geht.

Probleme …

Wir würden uns viel leichter tun, wenn wir beieinander säßen, und einfach die Histogramme unserer Kameras unter verschiedenen Kontrastsituationen betrachten könnten – dann würde jedem schnell klar werden, worum’s geht, und dann würden wahrscheinlich auch mehr Leute ein “Problem” sehen, über dass sie bislang vielleicht achselzuckend hinweg gesehen haben.

Vorab: Ich habe keine akuten Probleme, weil ich natürlich weiß, wie ich die Tonwerte in den Griff bekomme, unter den gegebenen Umständen. Aber es gibt schon ein paar grundsätzliche Zugänge, die einerseits nerven, nicht sehr zeitökonomisch sind, und die, bei näherer Betrachtung dann zu dem Schluß führen, den ich oben versucht habe zu skizzieren und zu beschreiben.

Es fängt einmal damit an, dass meine Cam einen Kontrastumfang von über 12 Blendenstufen verarbeiten kann, was ja an sich fein ist, aber die Tonwerausgabe mit einem Gamma erfolgt, der sich an den 8-bit-Jpegs orientiert – auch dann, wenn der Kontrastumfang der Aufnahme deutlich größer ist; und wenn er deutlich kleiner ist, dann auch. D.h., wenn die Belichtung von dieser Vorgabe abweicht, dann ist auf jeden Fall Korrekturbedarf angesagt (und dass und wie das geht, und dass man sich dafür auch Kurven “biegen” kann, ist auch nicht das Thema).

Dazu kommt dann aber noch der prinzipiell falsche Lapsus, dass die Belichtung, so wie sie messtechnisch geeicht ist, nicht darauf ausgelegt ist, die Sensorausgabe voll zu nutzen, sondern dass aus einem Kamerakontrast von 12 Blenden, auf die mittleren (!) 8 Blendenstufen belichtet wird – was zur Folge hat, dass ich, belichte ich “richtig”, mindestens 2 Blendenstufen in den Lichtern verliere, demnach die Bilder kontrastarm und wenig gesättigt erscheinen. Erfolgt dann eine Tonwertkorrektur verliere ich tatsächlich die beiden informationsreichsten Belichtungsstufen des Sensors …

Na gut, da ich das ja schon seit Jahren weiß, scher ich mich möglichst nicht ums “mittlere” Grau des Belichtungsmessers, sonder belichte konsequent auf die Lichter (auch nicht nach Lehrbuch, dem 18%-Grau, sondern mindestens auf den halben Remissionswert): also, Weiß +3,5 Stufen, sehr helle Farbtöne mind. +2 Stufen usw.

Das sorgt schon mal dafür, das Motive, die (zufällig) dem Ausgabekontrast entsprechen, weitgehend direkt übernommen werden können; dass der Kontrastumfang des Sensors maximal ausgereizt wird, und Aufhellungen der Schatten dezenter ausfallen können; und dass kontrastarme Motive, die bei einer solchen Behandlung sehr flau und zu hell erscheinen, idealer Weise nur noch in den Tiefen beschnitten werden müssen, also den Bereichen der geringeren Bildinformationen.

Daraus leiten sich dann folgende Schlussfolgerungen ab: Ich muss schon mal grundsätzlich dafür sorgen, dass die Bildinformation von den Lichtern her aufbereitet wird: dass also, egal ob kontrastarm oder kontrastreich, stets der Lichterbereich seitens des Sufnahmehistogramm voll belegt ist, und die Tiefen, je nach Kontrastumfang dann mehr oder weniger belegt sind. Dann ist die Gammakurve der Ausgabe an den Aufnahmekontrast anzupassen, d.h. ein starrer Verlauf, so wie jetzt, ist zu vermeiden. Und aus beiden Vorgaben ergibt sich dann drittens, dass die Tiefen von Haus aus, nämlich in den Bereichen, wo der Sensor keine Information aufzeichnen kann, schwarz ausfallen; während dort, wo Information vorhanden ist, auf Grund der angepassten Gammakurve, die Tonwerte weitestgehend natürlich ausfallen sollten. Damit sollten auch etwaige Sorgen um “Informationsverluste” ad acta gelegt sein, vor allem auch deswegen, weil diese Gammaanpassungen, vor einer Umwandlungen in Jpgs virtueller Natur sind, auch noch (kreativ) veränderbar sind; weil ja die Rohdaten die volle Sensorinformation auch stets neutral gespeichert haben. Und darum ist es auch nicht egal, wann und wo ich mit einer Optimierung ansetze, genauso wenig wie es ein stimmiges Argument ist, stets auf die Nachbearbeitung zu verweisen: Denn letztere profitiert vorrangig von einer tonwertrichtigen Aufbereitung der Daten – sei es, weil ich sie direkt übernehmen will – und dann auch kann, oder auch nur als optimale Ausgangslage für abweichende Gestaltungswünsche.

Der Anfang ist gemacht !

Ein durchaus richtiger, sehr guter Ansatz, rein technisch betrachtet (die Bildkomposition ist davon absolut unabhängig).

Durch den revolutionären Dual-Pixel-Autofokus, bei dem Canon den Phasendetektionsautofokus auf den Aufnahmesensor verlagert, ist der Anfang für diese “Digitale Zonenbelichtung” gemacht.

Wenn man das weiterspinnt, und weiterentwickelt, kann man nach dem gleichen Prinzip nicht nur die Phasenunterschiede beim Autofokus messen, sondern auch die Belichtungsunterschiede bei jedem “Dualpixel”. Durch einen starken Prozessor und intelligente Alghorithmen kann dann ein Zonenbelichtungssystem geschaffen werden.

Schade ist nur daß Canon diese Technologie bei einer “Mittelklassekamera” vorstellt, die längst nicht soviel Beachtung findet wie eine professionell abgestimmtere Kamera !

Den Zusammenhang zum AF

Den Zusammenhang zum AF verstehe ich nicht.

Der Sensor liefert doch (immer schon) die Belichtungswerte und ist damit zugleich ein großer, sehr detaillierter Belichtungsmesser. Dazu braucht es keine dualen Pixel, sondern lediglich Sensordaten *vor* der eigentlichen Belichtung des Bildes, aus denen man die Belichtungseinstellungen errechnen kann. Dieses “vor der Belichtung” ist das eigentliche Problem, weshalb es bei konventionellen DSLR so einfach nicht geht und ein separater Belichtungsmesser verwendet wird. Dieser allerdings hat auch wieder viele Pixel Auflösung (Beispiel D800: 91Tsd Pixel) und taugt insoweit zur Zonenmessung.

Auf den PUNKT gebracht!

Wo ist der Photoaltar? Ich möchte eine Kerze anzünden![quote=Plaubel]Genauigkeit in der Fotografie – davon lasst ab.

Denn um Eure Empfindungen sollt ihr euch kümmern nicht um die Methoden. Das Lebendige sollt ihr sehen. Die die da mit euch sind sollt ihr erkennen. Denn siehe, es ist noch immer ein Bild entstanden.

So spricht Plaubel: Nur jene Bilder, die ihr NICHT geplant und konstruiert habt, die ihr nicht begreifen könnt, erhöhen Eure Seele. Und wahrlich, ich sage euch: Euer Leben soll in euren Bildern sein nicht euer Hochmut.[/quote]

Hört sich an…

[quote=Plaubel]Genauigkeit in der Fotografie – davon lasst ab.

Denn um Eure Empfindungen sollt ihr euch kümmern nicht um die Methoden. Das Lebendige sollt ihr sehen. Die die da mit euch sind sollt ihr erkennen. Denn siehe, es ist noch immer ein Bild entstanden.

So spricht Plaubel: Nur jene Bilder, die ihr NICHT geplant und konstruiert habt, die ihr nicht begreifen könnt, erhöhen Eure Seele. Und wahrlich, ich sage euch: Euer Leben soll in euren Bildern sein nicht euer Hochmut.[/quote]

…wie die Predigt in der Kirche…

Sudel Eddi.

Wissen ist wie eine Laterne. Die Bekloppten halten sich an ihr fest, den Klugen leuchtet sie den Weg.

Genau

und all die Hersteller, die viel Geld und Hirnschmalz, manchmal sogar Herzblut (selten, ok) in immer bessere Kameras, immer feinere Objektive hineinstecken, tun das in der bösen Absicht, die geheiligte, so ohnehin seltene, Kreativität zu lähmen, die echten (echt? die gibt’s noch?) Bildergebnisse zu boykottieren … 😎

Grau ist alle Theorie

In der Praxis finden sich stets nur “Interpretationen”, gewürzt mit den falschen Annahmen des Autofokus, wohin die “genaue” Belichtung zu gewichten ist (30.000 abgespeicherte Motive – sic!). Die konkrete Belichtung wird letztlich wieder nur über einen Leisten gezogen, und wir sind weiter auf den Logenplatz hinterm Computer verwiesen … 😎

Auch wenn ich mich

jetzt vielleicht weit hinaushänge, aber ich vertrete dezitiert die Meinung, dass dieser ganze Aufwand mehr Hokuspokus, denn ein korrekter Ansatz zur tonwertrichtigen Motiverfassung ist (den halte ich vom Prinzip her für wesentlich einfacher realisierbar, wenn man die (Farb)Tonwerte eines Motivs, abhängig vom gegebenen Motivkontrast, einfach richtig abgestuft darstellt). Den AF halte ich dafür, aber das schrieb ich schon, für besonders entbehrlich, wenn nicht gar kontraproduktiv.

Aber wenn ich einfach konkrete Automatik-Belichtungsergebnisse betrachte, die damit zu Stande kommen (und mein berufliches Umfeld konfrontiert mich oft damit), dann habe ich gar nicht mehr so sehr das Gefühl, mich mit meiner Meinung all zu weit aus dem Fenster gehängt zu haben; was auch oft noch dadurch bestärkt wird, dass manche User die tiefe Überzeugung hegen, dass das, was da automatisch aus der Kamera kommt, eigentlich perfekt ist – bis man die Bilder einer Nachbehandlung unterzieht, wenigstens. 😉

Aber, nein, diese Meinung vertrete ich nicht nur gegenüber Nikons Zugang.

Der nachhaltigste Beitrag

der Matrixmessung zur Belichtungsmessung bestand darin, höhere Lichtwerte als 18 (bei 100 ASA) von der Wirksamkeit auf die Belichtungsfindung weitgehend auszuschließen … simply highlight control … 😎

miniLabs

akzeptieren zumeist nur sRGB Dateien in 8 Bit Größe. Von den insgesamt 256 Lichtstufen belegen beispielsweise die hellsten Lichter 128 für einen Lichtwert von 15, 64 für LW = 14, 32 für LW = 13 und der LW = 12 dürfte bereits im Rauschen untergehen. Folglich können maximal bis zu 4 Blendenwerten an Helligkeit reproduziert werden – unabhängig davon, ob die Kamera vielleicht im RAW-File bis zu 14 Bit (etwa 9 Lichtwertstufen) bei ihrer Nennempfindlichkeit abspeichern könnte.

Digital is only about convenience …

Da stimmt einiges nicht

8-bit-Jpegs stehen für ein Wiedergabevermögen von 8 Lichtwerten – die z.B. auf einem Monitor mit einem Kontrast von 1:256 auch voll dargestellt werden können. Auf Papier kommen davon tatsächlich nur etwa 5 Belichtungsstufen an (was am Papier, nicht an den Jpegs liegt).

Der Binärwert 128 steht eigentlich für ein mittleres Grau – eines Kontrastumfangs von 8 Stufen; somit für einen Remissionswert von 6,25% (der aber als 50%-Tonwert “interpretiert” wird).

Was auch noch wichtig zu verstehen ist: Die Aufzeichnung von Bildern erfolgt in der Regel mit einer wesentlich höheren Bitrate (12 – 16 Bit), die dann aber – zur Ausgabe – auf die bekannten 8 Bit gestaucht werden: Hier stehen die Zahlenwerte aber für die Tonwertstufen im Bild, und keineswegs für deren linearen Ursprung. Und mit konkreten Lichtwerten hat es jedenfalls auch nichts zu tun …

Eine 8-Bit-Aufzeichnung

[quote=Gast]akzeptieren zumeist nur sRGB Dateien in 8 Bit Größe. Von den insgesamt 256 Lichtstufen belegen beispielsweise die hellsten Lichter 128 für einen Lichtwert von 15, 64 für LW = 14, 32 für LW = 13 und der LW = 12 dürfte bereits im Rauschen untergehen. Folglich können maximal bis zu 4 Blendenwerten an Helligkeit reproduziert werden – unabhängig davon, ob die Kamera vielleicht im RAW-File bis zu 14 Bit (etwa 9 Lichtwertstufen) bei ihrer Nennempfindlichkeit abspeichern könnte.

Digital is only about convenience …[/quote]

ist nicht ident mit einer 8-Bit Ausgabe: Erstere verhielte sich tatsächlich so linear, wie beschrieben, weswegen sie auch in dieser Form nicht praktiziert wird. Letztere beschreibt die Tonwerte einer Bildausgabe; in 256 Stufen, mit einem Mittelwert bei 128

– das ist korrekt.

Ja, machen Sie

[quote=Gast][quote=Gast] den chemisch-analogen Foto-Apparaturen von anno Tobak [/quote]

Das war ja Fotografie. Damals wie heute. Die physikalisch-digitalen Foto-Apparaturen von anno Weissnix dagegen machen, ja, was eigentlich? Datensätze zur freien Manipulation![/quote]

Aber darin scheint sich ja für Manche die Digitalfotografie auch zu erschöpfen.

Muss man aber nicht so sehen … 😉

Vergebliche Liebesmüh…

Ich gebe zu, dass ich mich mit guten Gefühlen an das Zonensystem erinnere, aber diese Zeit ist doch nun wirklich vorbei und man muss keine Toten wiederbeleben wollen.

Ganz ehrlich: Dieser Beitrag hier in allen Ehren, aber man kann sich auch die Errungenschaften der Digitalfotografie schlechtreden, wenn man die modernen technischen Ressourcen nicht nutzt oder ignoriert.

Ich setze bei meiner Kritik mal voraus, dass Fotografen wissen, wie man den Motivkontrast am besten auf das zu verwendende Papier abbildet.

Wir haben heute paradiesische technische Möglichkeiten – alles ist möglich. Fotografische Technik war noch nie so einfach und modular anwendbar. Also lasst das Zonensystem ruhen. Dann bleibt Zeit, die man für einzigartige oder vielleicht sogar für nahezu perfekte fotografische Momente aufwenden kann. Das hilft, aus dem Bilder-Müllberg unserer Zeit herauszuragen. Denn das ist – angesichts der unkritischen und ungebildeten Masse – schwer genug.

Die Errungenschaften der Digitalfotografie

Das ursprüngliche Zonensystem gehört wohl sicher nicht dazu – und es ist auch nicht mein engeres Anliegen, es wiederzubeleben.

Ich wollte nur zeigen, dass man auf Basis einer Zonierung das Thema Kontraste und deren Optimierung im Bild besser verstehen – und vielleicht auch bei Bedarf gesetzmäßig anwenden kann.

Und wenn ich diesen Bedarf sehe, ist dies kein “Schlechtreden” (ganz im Gegenteil, wie alle wissen, die meine Affinität zur Digitalfotografie kennen), sondern einfach der Wunsch nach konsistenten Ergebnissen – aus der Kamera heraus, und nicht als (natürlich machbares) Ergebnis sich stets wiederholender, zeitraubender Tonwert- und anderer Korrekturen in der obligaten Bildbearbeitung.

Technologie ist ein ständiger Optimierungsprozess, von dem die Digitalfotografie natürlich keineswegs ausgenommen ist – auch wenn ihre Technik dazu verführen mag, dem Irrtum zu verfallen, hier schon am Ende der Geschichte angelangt zu sein (obwohl wir doch erst seit relativ kurzer Zeit über Kameras verfügen, die in ihren Ergebnissen einiger Maßen zu überzeugen vermögen). Eine weitere, dringende Baustelle wäre hier, aus meiner Sicht, auch das Thema Vollfarbtauglichkeit der Sensoren – mit der nicht unwesentlich auch die von mir angesprochene Kontrast- bzw. Belichtungsoptimierung eher steht denn fällt.

Auch wenn ich Plaubel

als begnadeten Spötter schätze – (seine) Verachtung der Digital-Technik mag ich nicht nachvollziehen.

Vielmehr äußert sich Hochmut für mich auch darin, dass man keinen Wert auf (sehr) gutes Werkzeug legt.

Über das, in der digitalen Welt unleugbare, unmäßig Mittelmäßige zu spotten, wirkt dann wie eine self-fullfilling prophecy.

Null Praxisrelevanz für Digitalfotografie

zum Glück braucht man in der Digitalfotografie keinerlei Zonen oder aufgeblasen-komplizierte Tabellen. Genauso wenig wie ein schwarzes Tuch über dem Kopf oder eine Dunkelkammer.

Im Gegensatz zu den chemisch-analogen Foto-Apparaturen von anno Tobak kann nämlich jede halbwegs vernünftige Digitalkamera bei Aufnahme ein “Live-Histogramm” anzeigen. Wenn man den von smarten japanischen Ingenieuren und Softwaregurus entwickelten Belichtungsmess- und -steuerungssystemen nicht traut und partout alles besserwisserisch selbst machen will, wählt man einfach die Belichtung so, dass der angezeigte Tonwertberg möglichst weit rechts ist, aber nicht abgeschnitten wird. Sollte gleichzeitig links etwas abgeschnitten sein, macht man eine kleine Belichtungsreihe und lässt die Kamera oder geeignete Software vollautomatisch aus den Aufnahmen das technisch optimale Bild erstellen. Fertig.

Ausgabeseitig ist das Thema sowieso müssig, solange die Rezipienten der Bilder zu 99,9% an nicht kalibrierten Monitoren sitzen, die nicht einmal sRGB zur Gänze darstellen können. Von Papierbildern für die Fotoalben der Ewiggestrigen erst gar nicht zu reden. Und die Rezipienten selbst haben zu 100% unkalibrierte Augen und Sehzentren.

Das Histogramm allein

sagt nur etwas darüber aus, wie sich der vorhandene Bildkontrast innerhalb des Darstellungsvermögens der Kamera darstellt – um dann mit mehr oder weniger fixen Vorgaben für die Darstellung aufbereitet zu werden.

Was aus diesen Vorgaben heraus alles machbar ist, ist nicht das Thema dieses Aufsatzes hier, sondern warum wir so viel (nachher) noch selber machen müssen, und wie dies unter Umständen vermeidbar wäre … 😎

Das sehen die Hersteller

vielleicht so ähnlich – oder auch nicht, wenn ich mir die eher bemühten Tools für eine bessere Tonwertkontrolle so anschau. Für mich besteht kein Widerspruch darin, einen (notwendigen) Workflow konsistent(er) zu gestalten – auch im Wissen darum, dass er nur dort voll zur Geltung kommt, wo er auch praktisch voll genutzt wird (werden kann).

Genau

[quote=Gast]zum Glück braucht man in der Digitalfotografie keinerlei Zonen oder aufgeblasen-komplizierte Tabellen. Genauso wenig wie ein schwarzes Tuch über dem Kopf oder eine Dunkelkammer.

Im Gegensatz zu den chemisch-analogen Foto-Apparaturen von anno Tobak kann nämlich jede halbwegs vernünftige Digitalkamera bei Aufnahme ein “Live-Histogramm” anzeigen. Wenn man den von smarten japanischen Ingenieuren und Softwaregurus entwickelten Belichtungsmess- und -steuerungssystemen nicht traut und partout alles besserwisserisch selbst machen will, wählt man einfach die Belichtung so, dass der angezeigte Tonwertberg möglichst weit rechts ist, aber nicht abgeschnitten wird. Sollte gleichzeitig links etwas abgeschnitten sein, macht man eine kleine Belichtungsreihe und lässt die Kamera oder geeignete Software vollautomatisch aus den Aufnahmen das technisch optimale Bild erstellen. Fertig.

Ausgabeseitig ist das Thema sowieso müssig, solange die Rezipienten der Bilder zu 99,9% an nicht kalibrierten Monitoren sitzen, die nicht einmal sRGB zur Gänze darstellen können. Von Papierbildern für die Fotoalben der Ewiggestrigen erst gar nicht zu reden. Und die Rezipienten selbst haben zu 100% unkalibrierte Augen und Sehzentren.[/quote]

Genau. 😉

Dem kann man nichts mehr hinzufügen.

Na doch: Ich denke, weil Fotografie heute so langweilig geworden ist, weil sie jeder in den technischen Punkten kontrollieren kann (wenn auch nicht “High End”, was auch gut so ist, sonst bleibt mir und ähnlichen Leuten nichts mehr), wird immer wieder nach einem Strohhalm gesucht um “die Fotografie” retten zu können. Aber “die Fotografie” wurde vom technischen Fortschritt eingeholt und demokratisiert. Heute muss man sich über echte Bildergebnisse profilieren (worum es eigentlich, ja eigentlich auch früher schon ging) und das ist endlich so schwer und so öffentlich, wie es schon immer sein sollte.

Fie Reaktionen darauf

unterscheiden sich auch nicht so sehr von denen fundamental Gläubiger … 😎

Gast schrieb:

den

[quote=Gast] den chemisch-analogen Foto-Apparaturen von anno Tobak [/quote]

Das war ja Fotografie. Damals wie heute. Die physikalisch-digitalen Foto-Apparaturen von anno Weissnix dagegen machen, ja, was eigentlich? Datensätze zur freien Manipulation!

Um der philosophischen Frage…

eine technische Antwort entgegenzusetzen, wurde in der “guten, alten Zeit” der analogen Reproduktionsfotografie mit Hilfe von gammavariabelen Filmen und den dazugehörigen Belichtungsberechnungen per Isodensiten-Kurven das Problem gelöst. Allerdings war dieser – aufwendige – Prozeß ein korrektiver Eingriff, der die unterschiedliche Kontrastwiedergabe von z.B Diafilm und dem Ausgabemedium z.B. Illustrierte kompensieren konnte.

Diese Technik erübrigte sich mit der Verbreitung hochwertiger Trommelscanner, deren Farbrechner dem Scanneroperator erlaubten, die “Rohdaten” des Diapositivs dem Druckprozeß anzupassen. Flachbettscanner folgten,

waren aber im Nachteil, da diese ohne Photomultiplier auskommen mußten. Jetzt dürfen sich die Kamerahersteller mit den Problemen rumschlagen. Der Akkumulation unseres Sehvermögens etwas entgegen zu setzen, ist weit mehr als eine philosophische Frage. Aber um Ihre technische Frage zu beantworten: AGFA-GEVAERT hatte mit der Entwicklung des gammavariabelen Films, einen wesentlichen Beitrag geleistet. Dieser Ansatz könnte bei Sensoren mit Dual-Dioden zur Anwendung kommen.

Ein pragmatischer Ansatz:

Nicht ohne Grund empfiehlt man ja generell das Fotografieren eher in den frühen Morgenstunden und am späten Nachmittag. Unabhängig davon, ob man das harte Mittagslicht nun ästhetisch findet oder nicht: Für Digitalkameras sind die starken Kontraste bei dieser grellen Beleuchtung ein harter Prüfstein. Verlorene Tiefen beziehungsweise verlorene Lichter sind bei diesen Bedingungen fast unvermeidlich.

Eine andere Möglichkeit ist das aktive Senken des Motivkontrastes. Hierfür eignen sich beispielsweise gezielt eingesetzte Aufhellblitze. Mit dem Aufhellen der Schattenbereiche sinkt dann der Tonwertumfang des Motivs.

All das sind aber mehr oder weniger Notlösungen. Erst eine neue Generation von Bildsensoren mit deutlich erhöhtem Kontrastumfang würde hier eine sichtbare Verbesserung bringen. [http://www.scandig.info/Belichtungsmessung.html]

Als ob es überhaupt nicht mehr auf ein Motiv ankommt…

Nach Überfliegen dieses Traktats und der Diskussion habe ich das unbestimmte Gefühl, dass für den einen oder anderen ein perfekt belichteter Langweiler das bessere Foto ist, als ein blitzschnell erfasstes und toll umgesetztes Motiv, dem die letzte Vollkommenheit in Licht und Kontrast fehlt. Erstaunlich…

R aus NRW

Technische

Beiträge haben es so an sich, nicht vorrangig Kreativität im Auge zu haben … wobei eine gute technische Grundlage einer wie immer gearteten Kreativität eher zuträglich sein sollte, als diese abzuwerten (eine Technik, die sich mir – haptisch, praktisch – nicht in den Weg stellt, meine Vorstellungen bestmöglich umsetzt, habe ich schon immer als inspirierender empfunden, als eine Technik, die sich um ihrer selbst willen eitel in den Vordergrund drängt, oder mir ihre “Besonderheit” als Vorgabe aufdrängt).

Na, und wie’s auf Motive ankommt …

Aber warum unbedingt mit imperfektem Aufnahmegerät …? 😎

Der praktische Ansatz:

Für Schnappschüsse auf Silberhalogenidfilm – etwa einem Ilford HP5 plus – belichte ich ohne Messwerte nur nach “Augenmaß” passend zum (hohen) Motivkontrast und entwickle den Film für 25°Din/250ASA in Perceptol festgradationsgerecht gemäß der Ilford Tabelle.

Inszenierte Aufnahmen ab Stativ im Mittelformat (FP4+ & Perceptol 21°Din/100ASA) funktionieren so ebenfalls prima.

Mit meiner 24x36mm DSLR verlasse ich mich auf die Blendenautomatik (ESP) bei Nennempfindlichkeit mit offener Blende und im Live-View-Modus (mit Stativ) stimme ich manuell auf ETTR ab. Die RAW-Files konvertiere ich mittels PS und rechne die Print-Datei auf 2.400×3.600 Pixel bikubisch kleiner, um die systembedingten Interpolationsverluste zu kompensieren. Ein Nachschärfen entfällt daher!

Gebrauchsfotos (etwa für’s iPad oder als eMail-Anhang) erstelle ich “digital” und zur Rahmung geeignete Motive vorzugsweise “analog” in SW als Handabzug auf Silbergelantine-Barytpapier in Kartonstärke.

Wir haben alle

unsere Mittel und Methoden, um mit dem, was an Technik vorhanden ist so umzugehen, dass wir und andere mit den Ergebnissen gut leben können und zufrieden sind

Aber selbst der Film hat über die Jahrzehnte seines Bestehens eine ständige Weiterentwicklung erfahren – und sich zu einem Medium entfaltet, das im Rahmen seiner Grenzen wenig Wünsche offen ließ.

Die Digitalfotografie, wie wir sie heute verwenden, ist grad mal im Teenager-Alter ihrer Entwicklung angelangt – verträgt also durchaus noch einige Jahrzehnte der Evolution. Dafür vielleicht einen kleinen Denkanstoß zu liefern, war und ist mein hier eingebrachtes Anliegen.

Christian,

auch beim

Christian,

auch beim wiederholten Lesen habe ich Probleme, die Neuigkeit und den Nutzen dieser Methodik zu erkennen. Beim analogen Zonensystem wurde durch eine Kombination aus angepasster Entwicklung und Belichtung der Kontrastumfang des Mediums auf das Motiv angepasst. Das ist bei digitaler Fotografie in RAW nur von begrenztem Nutzen, weil die 12/14 bit Rohdaten die Sensordaten vollständig wiedergeben und sich daraus der Bildinhalt mit gewünschtem Kontrast nachträglich ableiten lässt. Die Belichtungssteuerung wird bei Hochkontrastmotiven ebenfalls automatisch angepasst (bei Nikon heisst das Active D-Lighting), um mehr Spielraum in den Lichtern zu schaffen, und ansonsten gibt sich eine Matrixmessung alle Mühe, dem jeweiligen Motivkontrast in der Belichtung Rechnung zu tragen. Worin liegen nun Neuigkeit/Nutzen deines Ansatzes, das ist mir nicht klar geworden.

Ich versuch’s stückweise:

[quote]Es ist logisch notwendig, dass bei gleicher Belichtung, aber unterschiedlichem Motivkontrast, die Kontrast„kurven“ angepasst und signalmäßig asymmetrisch verstärkt werden müssen – je höher der Kontrastumfang, desto stärker.[/quote]

Das ist üblicher Stand der Technik.

[quote]Die Belichtungsermittlung erfolgt nicht mehr (allein) über einen (mittleren) Referenzwert, sondern leitet sich vorrangig aus dem vom Sensor erfassten Kontrastumfang einer Szenerie ab.[/quote]

Das ist üblicher Stand der Technik, mit zusätzlichen Korrekturen und Plausibilitätsprüfungen (weißer Hund im Schnee).

[quote]Die Belichtungsinformation geschieht nicht mehr über eine klassische Lichtwaage, auch nicht über ein komplexes Histogramm, sondern der Fotograf bekommt über eine „Zonenwaage“ die Information vermittelt, welchen Tonwertumfang sein Motiv belegt, bzw. welchem Tonwert ein angemessenes Motivdetail entspricht. [/quote]

Das ist in dieser Ausführung in den Kameras unüblich.

Einzelne Handbelichtungsmesser (z.B, Sekonic 758DR) bieten diese Funktion an. Vgl. Blog/Webcast von Sekonic “Mastering Exposure for Landscape Photography”

[quote]Belichtungstechnisch ermöglicht das Zonensystem exakt definierte Belichtungsänderungen, abhängig vom vorhandenen (oder auch wählbaren) Motivkontrast; da jeweils ein 100-‰-Sprung auf der Zonenskala genau 1/10 des Gesamtmotivkontrasts, somit des Belichtungsumfangs, entspricht.

Die notwendige Belichtungsanhebung ist mathematisch exakt definiert: Entspricht ein 10-%-Grauwert bei einem Kontrast von 1:100 einem Zonenwert von 500 ‰, so gilt bei einem Kontrast von 1:1000 ein 666-‰-Zonenwert. Seine Position liegt demnach, bezogen auf den Belichtungsumfang von 10 Belichtungsstufen, 16,6 % höher. Eine Signalverstärkung entspricht genau diesem Prozentsatz, umfasst also konkret 1,66 Lichtwerte. Diese Regel gilt, ausgehend vom geringst darstellbaren Kontrastumfang, für alle darzustellenden Belichtungswerte und ist entsprechend anzuwenden.[/quote]

Langer Text, ich versuche eine kurze Darstellung. Belichtungsrelevant sind die darstellbaren Spitzlichter, der Rest ergibt sich (Sensor-Rohwerte linear, Auflösung der Datei-Rohdaten ergibt sich aus A/D Wandler 12/14 bit). Aus diesen Rohdaten lässt sich im RAW-Workflow nachträglich alles Gewünschte errechnen/herstellen, ohne Verluste. Die Anwendung einer geeigneten Kurve (die Logarithmierung, der du in deinem beitrag so viele Tabellen schenkst) ist im RAW-Workflow nur Postprocessing. An der Kamera müsste man also gar nichts ändern.

[quote]Sollte der Kontrastumfang eines Motivs das Aufzeichnungsvermögen des Sensors übersteigen, so lässt sich das Zonen-Prinzip auch auf eine dann notwendige HDR-Belichtung anwenden. [/quote]

Ja.

[quote]Der letztliche Ausgabekontrast hat keinen unmittelbaren Einfluss auf die Positionierung der Lichtwerte auf der Zonenskala; weswegen die Zonenskala auch nicht belichtungstechnisch relevant ist, sondern einfach einen Referenzmaßstab dafür liefert, mit welchem Tonwert ein bestimmter Belichtungswert (im Ausgabemedium) darzustellen ist.[/quote]

Ja.

[quote] Bezüglich der Farbdarstellung gelten die gleichen Zonen-Regeln: Es wird also jeder Farbwert, ausgehend vom Motivkontrast, exakt auf der Zonenskale verortet und damit in seiner Farb(ton)darstellung genau festgelegt.[/quote]

Fülltext?

[quote] Eine zumindest 10-Bit-Ausgabe wäre im Hinblick auf eine genauere Darstellung auch kontrastreicher Motive möglichst anzustreben, der gültige 8-Bit-JPEG-Standard grundsätzlich zu hinterfragen.[/quote]

Seit wenigen Jahren hat die Monitor-Hardware nun Auflösung von 10 bit und mehr, insoweit hätte es nun einen Nutzen. Für andere Ausgabemedien ist 16 bit Verarbeitung bis zur Ausgabe ohnehin schon seit vielen Jahren üblich, um feine Tonwertabstufung zu ermöglichen.

[quote]Es drängt sich der zwingende Verdacht auf, dass ein solches Verständnis von Belichtung auch entsprechende Auswirkungen auf die Funktion von Belichtungsautomatiken haben muss.[/quote]

Ja, sicher. Aber der Stand der Technik dort ist sehr viel weiter, als du es hier unterstellt hast. Die modernen Belichtungsalgorithmen messen den Motivkontrast sehr detailliert aus und nutzen das für angepasst Belichtung, auch unter Nutzung der AF-Information. Nennt sich bei Nikon 3D-Matrixmessung und wird seit den 1990ern verwendet.

Ja, aber

Es ist grundsätzlich richtig, dass vieles von dem, was ich angesprochen habe, natürlich auf Vorhandenem aufbaut – dass es allerdings auch evident ist, dass vieles von dem, das theoretisch erfolgen sollte, in der Praxis nicht so funktioniert, wie von den Herstellern angepriesen – und schon gar nicht so, wie es sich aus einer wirklich konsequenten Umsetzung in gültige Tonwerte darstellen müßte. Ich versuch’ jetzt mal – auch stückweise – auf die angesprochenen Punkte einzugehen:

1. Es findet ganz offensichtlich keine Änderung der Gammawerte statt – allein Tonwertkorrekturen durch das “Verbiegen” eines vorgegebenen Gammas.

2. Nein, eine Belichtung nach Kontrast(umfang) – gar eine Anpassung des Kontrastumfangs nach den Ausgabemöglichkeiten – findet nicht statt; wie man einfach mit einer Messung auf eine Graukarte nachvollziehen kann – und wie ein Blick auf’s Histogramm nachdrücklich belegt.

3. Ja, eine “Zonen”waage ist in dieser Form “unüblich” – wäre aber, da nach oben und unten absolut begrenzt, wesentlich hilfreicher bei der Belichtung (wie auch ein Histogramm u.U. hilfreicher ist) …

4. Ich stelle keineswegs in Abrede, dass sich im RAW-Daten-Workflow eine weitgehende Anpassung von Tonwerten realisieren läßt – ich stelle nur die Frage (und versuche eine Antwort zu geben) wie das im heute nötigen Umfang vielleicht nicht mehr unbedingt notwendig wäre, wenn …

5. Nein, kein “Fülltext”, sondern nur ein dezenter Hinweis darauf, dass ich die Farbdarstellung als wesentlich hinsichtlich der Tonwert-Zuordnung erachte – dass sie ein wesentlicher Aspekt meines Zugangs zum Thema ist, auf den ich, zur Vereinfachung, nur nicht näher eingehen wollte.

6. Ja, Monitor-Hardware und auch das Thema Video haben mir den Weg zu den 10 Bit nahe gelegt – mehr noch aber die elegante Konvergenz mit den 10 Zonen bzw. 100 Tonwert-Prozent … außerdem hab’ ich nicht vergessen “mindestens” dazu zu schreiben. 😉

7. Hinsichtlich automatischer Belichtung scheint mir Vieles von dem, was die Hersteller da an Technologie – richtig, schon seit Jahrzehnten – hineinverpackt haben, immer noch recht klägliche Ergebnisse abzuwerfen – vor allem dort, wo die Helligkeits- und Kontrastverteilung stark von der vorgegebenen Norm abweicht. Die Einbeziehung des AF hat darüber hinaus auch noch dafür gesorgt, dass Automatiken oft dem Trugschluss unterliegen (müssen), dass das scharf zu stellende Objekt immer auch das “richtig” zu belichtende sei …

Ich glaube,

dass ist hier der erste Artikel überhaupt, wo der Autor selber mehr Kommentare schreibt als seine Leser…

Dieser Eindruck

[quote=Gast]dass ist hier der erste Artikel überhaupt, wo der Autor selber mehr Kommentare schreibt als seine Leser…[/quote]

mag tatsäcnlich entstehen – weil ich mich bemühe, allen zu antworten. Und, ich wollte meinen Beitrag ausdrücklich zur Diskussion stellen – wozu denn auch mindestens Zwei gehören.

Aber keine Sorge, ist das Thema ad acta gelegt, bin ich wieder ganz und gar ‘Gast’ … 😉

Technik hin oder her …

… ich halt’s da mit HCB – ich mache einfach nur Bilder, das ist wichtiger … ich habe gar nicht die Zeit für Physik, ist aber auch nicht nötig; in fast 40jähriger Fotografiepraxis habe ich ein natürliches Verhältnis von Blende zu Zeit entwickelt, die kleinen Nuancen, die dann noch fehlen hole ich in der Duka oder am Computer noch heraus – darin unterscheide ich mich von HCB, der kaum eines seiner vielen hervorragenden Bilder jemals selbst abgezogen hätte, eigenen Angaben zufolge konnte und wollte er dies v.a. nicht.

HCB

wäre ohne seinen Laboranten recht aufgeschmissen gewesen, so sehr, wie er sich dem Thema Belichtung verweigert hatte … nein, man muss sich nicht mit Technik auseinandersetzen – solang’ man’s delegieren kann. 😎

So ist es

HCB hatte kein Interesse an Technik – dafür aber einen begnadeten Laboranten.

Und: Der Film hatte andere Rahmenbedingungen, als die Digitalfotografie hat (die hat mehr Freiheitsgrade).

Aber, wenn Sie meine Ausführungen richtig deuten, dann erschließt sich daraus auch ein Zugang, uns von technischen Einschränkungen freier zu machen; als Voraussetzung dafür, uns auch wirklich vorrangig auf’s Fotografieren konzentrieren zu können (und nicht fremder Hilfe zu bedürfen).